Apache Beam 编程指南

**Beam 编程指南** 面向想要使用 Beam SDK 创建数据处理管道的 Beam 用户。它提供了使用 Beam SDK 类构建和测试管道的指南。编程指南并非旨在作为详尽的参考,而是作为一种与语言无关的、高级的编程构建 Beam 管道的指南。随着编程指南的完善,文本将包含多种语言的代码示例,以帮助说明如何在管道中实现 Beam 概念。

如果您想在阅读编程指南之前简要介绍 Beam 的基本概念,请查看Beam 模型基础页面。

- Java SDK

- Python SDK

- Go SDK

- TypeScript SDK

- Yaml API

Python SDK 支持 Python 3.8、3.9、3.10、3.11 和 3.12。

The Go SDK 支持 Go v1.20+。

Typescript SDK 支持 Node v16+,目前仍处于实验阶段。

YAML 从 Beam 2.52 开始支持,但仍在积极开发中,建议使用最新版本的 SDK。

1. 概述

要使用 Beam,您需要首先使用 Beam SDK 中的类创建一个驱动程序程序。您的驱动程序程序定义您的管道,包括所有输入、变换和输出;它还为您的管道设置执行选项(通常使用命令行选项传递)。这些选项包括 Pipeline Runner,它反过来决定您的管道将在哪个后端运行。

Beam SDK 提供了许多抽象,简化了大规模分布式数据处理的机制。相同的 Beam 抽象适用于批处理和流数据源。创建 Beam 管道时,您可以从这些抽象的角度考虑数据处理任务。它们包括

Pipeline:Pipeline封装了从头到尾的整个数据处理任务。这包括读取输入数据、转换该数据以及写入输出数据。所有 Beam 驱动程序程序都必须创建一个Pipeline。创建Pipeline时,您还必须指定执行选项,这些选项告诉Pipeline在哪里以及如何运行。PCollection:PCollection表示 Beam 管道操作的分布式数据集。数据集可以是有界的,这意味着它来自固定源(如文件),也可以是无界的,这意味着它来自通过订阅或其他机制不断更新的源。您的管道通常通过从外部数据源读取数据来创建初始PCollection,但您也可以从驱动程序程序中的内存数据创建PCollection。从那里开始,PCollection是管道中每个步骤的输入和输出。PTransform:PTransform表示数据处理操作或管道中的一个步骤。每个PTransform都会接受一个或多个PCollection对象作为输入,对该PCollection元素执行您提供的处理函数,并产生零个或多个输出PCollection对象。

Scope:Go SDK 有一个显式的作用域变量,用于构建Pipeline。Pipeline可以使用Root()方法返回其根作用域。作用域变量传递给PTransform函数,以将其放置在拥有Scope的Pipeline中。

- I/O 变换:Beam 带有许多“IO” - 库

PTransform,用于读取或写入各种外部存储系统的数据。

PCollection 是隐式的(例如,在使用 chain 时),或者由其生成 PTransform 引用。典型的 Beam 驱动程序程序的工作方式如下

- **创建**一个

Pipeline对象并设置管道执行选项,包括 Pipeline Runner。 - 为管道数据创建一个初始

PCollection,方法是使用 IO 从外部存储系统读取数据,或者使用Create变换从内存数据构建PCollection。 - 将

PTransform**应用**于每个PCollection。变换可以更改、筛选、分组、分析或以其他方式处理PCollection中的元素。变换会创建一个新的输出PCollection,不会修改输入集合。典型的管道依次将后续变换应用于每个新的输出PCollection,直到处理完成。但是,请注意,管道不必是依次应用的一系列变换的直线:将PCollection视为变量,将PTransform视为应用于这些变量的函数:管道的形状可以是任意复杂的处理图。 - 使用 IO 将最终的、转换后的

PCollection写入外部源。 - 使用指定的 Pipeline Runner **运行**管道。

运行 Beam 驱动程序程序时,您指定的 Pipeline Runner 会根据您创建的 PCollection 对象和应用的变换,构建您管道的工作流图。然后,该图使用适当的分布式处理后端执行,成为该后端的异步“作业”(或等效项)。

2. 创建管道

Pipeline 抽象封装了数据处理任务中的所有数据和步骤。Beam 驱动程序程序通常从构建一个Pipeline Pipeline Pipeline 对象开始,然后使用该对象作为创建管道的 PCollection 数据集和 Transform 操作的基础。

要使用 Beam,您的驱动程序程序必须首先创建一个 Beam SDK 类 Pipeline 的实例(通常在 main() 函数中)。创建 Pipeline 时,还需要设置一些配置选项。您可以以编程方式设置管道的配置选项,但通常通过提前设置选项(或从命令行读取)并在创建对象时将它们传递给 Pipeline 对象会更容易。

有关在 Python SDK 中创建基本管道的更深入教程,请阅读和完成此 colab 笔记本。

2.1. 配置管道选项

使用管道选项配置管道的不同方面,例如执行管道的管道运行程序以及所选运行程序所需的任何运行程序特定配置。您的管道选项可能会包含项目 ID 或用于存储文件的位置等信息。

在您选择的运行程序上运行管道时,PipelineOptions 的副本将可用于您的代码。例如,如果您将 PipelineOptions 参数添加到 DoFn 的 @ProcessElement 方法中,它将由系统填充。

2.1.1. 从命令行参数设置 PipelineOptions

虽然您可以通过创建 PipelineOptions 对象并直接设置字段来配置管道,但 Beam SDK 包含一个命令行解析器,您可以使用它通过命令行参数在 PipelineOptions 中设置字段。

要从命令行读取选项,请按照以下示例代码中的演示构建 PipelineOptions 对象

使用 Go 标志解析命令行参数以配置您的管道。在调用 beam.Init() 之前必须解析标志。

任何 Javascript 对象都可以用作管道选项。可以手动构建一个,但通常也传递从命令行选项创建的对象,例如 yargs.argv。

管道选项只是与管道定义本身处于同级关系的可选 YAML 映射属性。它将与在命令行上传递的任何选项合并。

这将解释遵循以下格式的命令行参数

--<option>=<value>

附加方法

.withValidation将检查必需的命令行参数并验证参数值。

通过这种方式构建 PipelineOptions 使您可以将任何选项指定为命令行参数。

通过这种方式定义标志变量使您可以将任何选项指定为命令行参数。

注意:WordCount 示例管道演示了如何通过使用命令行选项在运行时设置管道选项。

2.1.2. 创建自定义选项

除了标准 PipelineOptions 之外,您还可以添加自己的自定义选项。

要添加自己的选项,请为每个选项定义一个带有 getter 和 setter 方法的接口。

以下示例展示了如何添加input 和 output 自定义选项您还可以指定说明,该说明会在用户传递 --help 作为命令行参数时出现,以及默认值。

您可以使用注释设置说明和默认值,如下所示

public interface MyOptions extends PipelineOptions {

@Description("Input for the pipeline")

@Default.String("gs://my-bucket/input")

String getInput();

void setInput(String input);

@Description("Output for the pipeline")

@Default.String("gs://my-bucket/output")

String getOutput();

void setOutput(String output);

}from apache_beam.options.pipeline_options import PipelineOptions

class MyOptions(PipelineOptions):

@classmethod

def _add_argparse_args(cls, parser):

parser.add_argument(

'--input',

default='gs://dataflow-samples/shakespeare/kinglear.txt',

help='The file path for the input text to process.')

parser.add_argument(

'--output', required=True, help='The path prefix for output files.')对于 Python,您也可以简单地使用 argparse 解析自定义选项;无需创建单独的 PipelineOptions 子类。

建议您使用 PipelineOptionsFactory 注册接口,然后在创建 PipelineOptions 对象时传递接口。使用 PipelineOptionsFactory 注册接口时,--help 可以找到您的自定义选项接口并将其添加到 --help 命令的输出中。PipelineOptionsFactory 还将验证您的自定义选项是否与所有其他已注册选项兼容。

以下示例代码展示了如何使用 PipelineOptionsFactory 注册自定义选项接口

现在,您的管道可以接受 --input=value 和 --output=value 作为命令行参数。

3. PCollections

The PCollection PCollection PCollection 抽象表示一个可能分布式、多元素的数据集。您可以将 PCollection 视为“管道”数据;Beam 变换使用 PCollection 对象作为输入和输出。因此,如果您想在管道中使用数据,则它必须采用 PCollection 的形式。

创建 Pipeline 后,您需要通过某种方式开始创建至少一个 PCollection。您创建的 PCollection 作为管道中第一个操作的输入。

3.1. 创建 PCollection

您可以通过以下两种方式创建 PCollection:使用 Beam 的 Source API 从外部数据源读取数据,或者在您的驱动程序中创建包含内存中集合类数据的 PCollection。前者通常是生产管道摄取数据的方式;Beam 的 Source API 包含适配器,可以帮助您从外部数据源(如大型基于云的文件、数据库或订阅服务)读取数据。后者主要用于测试和调试目的。

3.1.1. 从外部来源读取

要从外部数据源读取数据,您需要使用一个 Beam 提供的 I/O 适配器。适配器在具体用法上有所不同,但它们都会从某个外部数据源读取数据,并返回一个 PCollection,其元素代表该数据源中的数据记录。

每个数据源适配器都有一个 Read 变换;要读取数据,您必须将该变换应用于 Pipeline 对象本身。 将此变换放在管道的 source 或 transforms 部分。 TextIO.Read io.TextFileSource textio.Read textio.ReadFromText,ReadFromText,例如,从外部文本文件读取数据,并返回一个 PCollection,其元素 的类型为 String,其中每个 String 代表文本文件中的一个行。以下是如何将 TextIO.Read io.TextFileSource textio.Read textio.ReadFromText ReadFromText 应用于您的 Pipeline root 以创建 PCollection 的示例:

public static void main(String[] args) {

// Create the pipeline.

PipelineOptions options =

PipelineOptionsFactory.fromArgs(args).create();

Pipeline p = Pipeline.create(options);

// Create the PCollection 'lines' by applying a 'Read' transform.

PCollection<String> lines = p.apply(

"ReadMyFile", TextIO.read().from("gs://some/inputData.txt"));

}请参阅 有关 I/O 的部分,以了解有关如何从 Beam SDK 支持的各种数据源读取数据的更多信息。

3.1.2. 从内存数据创建 PCollection

要从内存中的 Java Collection 创建 PCollection,您需要使用 Beam 提供的 Create 变换。与数据适配器的 Read 非常相似,您将 Create 直接应用于 Pipeline 对象本身。

作为参数,Create 接受 Java Collection 和 Coder 对象。Coder 指定了如何 编码 Collection 中的元素。

要从内存中的 list 创建 PCollection,您需要使用 Beam 提供的 Create 变换。将此变换直接应用于 Pipeline 对象本身。

要从内存中的 slice 创建 PCollection,您需要使用 Beam 提供的 beam.CreateList 变换。将管道 scope 和 slice 传递给此变换。

要从内存中的 array 创建 PCollection,您需要使用 Beam 提供的 Create 变换。将此变换直接应用于 Root 对象。

要从内存中的 array 创建 PCollection,您需要使用 Beam 提供的 Create 变换。在管道本身中指定元素。

以下代码示例展示了如何从内存中的 List list slice array 创建 PCollection。

public static void main(String[] args) {

// Create a Java Collection, in this case a List of Strings.

final List<String> LINES = Arrays.asList(

"To be, or not to be: that is the question: ",

"Whether 'tis nobler in the mind to suffer ",

"The slings and arrows of outrageous fortune, ",

"Or to take arms against a sea of troubles, ");

// Create the pipeline.

PipelineOptions options =

PipelineOptionsFactory.fromArgs(args).create();

Pipeline p = Pipeline.create(options);

// Apply Create, passing the list and the coder, to create the PCollection.

p.apply(Create.of(LINES)).setCoder(StringUtf8Coder.of());

}lines := []string{

"To be, or not to be: that is the question: ",

"Whether 'tis nobler in the mind to suffer ",

"The slings and arrows of outrageous fortune, ",

"Or to take arms against a sea of troubles, ",

}

// Create the Pipeline object and root scope.

// It's conventional to use p as the Pipeline variable and

// s as the scope variable.

p, s := beam.NewPipelineWithRoot()

// Pass the slice to beam.CreateList, to create the pcollection.

// The scope variable s is used to add the CreateList transform

// to the pipeline.

linesPCol := beam.CreateList(s, lines)3.2. PCollection 特性

PCollection 由其创建的特定 Pipeline 对象拥有;多个管道不能共享一个 PCollection。 在某种程度上,PCollection 的功能类似于 Collection 类。但是,PCollection 在几个关键方面有所不同:

3.2.1. 元素类型

PCollection 的元素可以是任何类型,但必须都是相同的类型。但是,为了支持分布式处理,Beam 需要能够将每个单独的元素编码为字节字符串(以便可以将元素传递到分布式工作器)。Beam SDK 提供了数据编码机制,其中包含对常用类型的内置编码以及对根据需要指定自定义编码的支持。

3.2.2. 元素模式

在许多情况下,PCollection 中的元素类型具有可以内省的结构。例如 JSON、Protocol Buffer、Avro 和数据库记录。模式提供了一种将类型表示为一组命名字段的方式,从而允许进行更具表达性的聚合。

3.2.3. 不可变性

PCollection 是不可变的。创建后,您不能添加、删除或更改单个元素。Beam 变换可能会处理 PCollection 的每个元素并生成新的管道数据(作为新的 PCollection),但它不会使用或修改原始输入集合。

注意: Beam SDK 避免了对元素的不必要复制,因此

PCollection的内容在逻辑上是不可变的,而不是物理上不可变的。对输入元素的更改可能对在同一捆绑包中执行的其他 DoFns 可见,并且可能会导致正确性问题。通常,修改提供给 DoFns 的值是不安全的。

3.2.4. 随机访问

PCollection 不支持对单个元素的随机访问。相反,Beam 变换会单独考虑 PCollection 中的每个元素。

3.2.5. 大小和有界性

PCollection 是一个大型的、不可变的元素“集合”。PCollection 可以包含的元素数量没有上限;任何给定的 PCollection 都可能适合在一台机器上的内存中,或者它可能代表一个非常大的分布式数据集,该数据集由持久性数据存储支持。

PCollection 的大小可以是有界的,也可以是无界的。有界 PCollection 代表一个已知固定大小的数据集,而无界 PCollection 代表一个无限大小的数据集。PCollection 是有界还是无界取决于它代表的数据集的来源。从批处理数据源(如文件或数据库)读取数据会创建有界 PCollection。从流式数据源或持续更新的数据源(如 Pub/Sub 或 Kafka)读取数据会创建无界 PCollection(除非您明确告诉它不要这样做)。

PCollection 的有界(或无界)性质会影响 Beam 处理数据的方式。有界 PCollection 可以使用批处理作业进行处理,该作业可能会读取整个数据集一次,并在有限长度的作业中执行处理。无界 PCollection 必须使用持续运行的流式作业进行处理,因为整个集合永远不可能在任何时间点都可用以进行处理。

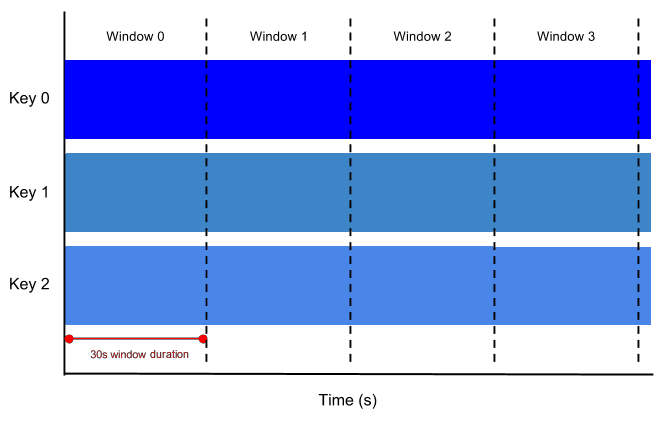

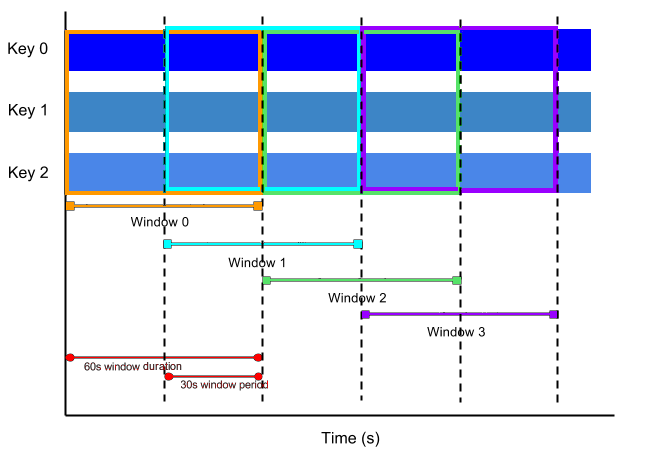

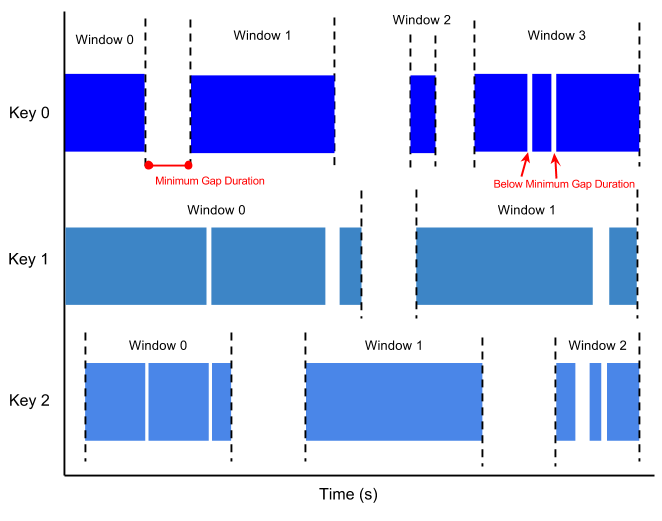

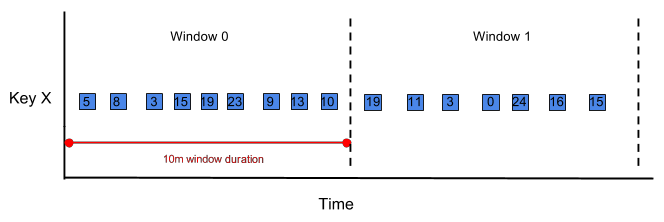

Beam 使用 窗口化 将持续更新的无界 PCollection 分为有限大小的逻辑窗口。这些逻辑窗口由与数据元素相关联的某些特征确定,例如时间戳。聚合变换(如 GroupByKey 和 Combine)按窗口为单位工作——随着数据集的生成,它们将每个 PCollection 处理为这些有限窗口的连续序列。

3.2.6. 元素时间戳

PCollection 中的每个元素都具有关联的内在时间戳。每个元素的时间戳最初由创建 PCollection 的 Source 分配。创建无界 PCollection 的源通常会为每个新元素分配一个时间戳,该时间戳对应于读取或添加元素的时间。

注意:为固定数据集创建有界

PCollection的源也会自动分配时间戳,但最常见的行为是为每个元素分配相同的时间戳(Long.MIN_VALUE)。

时间戳对于包含具有固有时序概念的元素的 PCollection 非常有用。如果您的管道正在读取事件流,例如推文或其他社交媒体消息,则每个元素可能使用事件发布的时间作为元素时间戳。

如果源没有为您分配时间戳,您可以手动将时间戳分配给 PCollection 的元素。如果您需要这样做,则元素本身具有固有的时间戳,但时间戳位于元素结构中的某个地方(例如服务器日志条目中的“时间”字段)。Beam 有 变换,它们以 PCollection 作为输入,并输出具有附加时间戳的相同 PCollection;有关如何执行此操作的更多信息,请参阅 添加时间戳。

4. 转换

变换是管道中的操作,并提供了一个通用的处理框架。您以函数对象的形式提供处理逻辑(俗称“用户代码”),并且您的用户代码将应用于输入 PCollection(或多个 PCollection)的每个元素。根据您选择的管道运行器和后端,集群中的许多不同的工作器可能会并行执行用户代码的实例。在每个工作器上运行的用户代码将生成最终添加到变换生成的最终输出 PCollection 中的输出元素。

在学习 Beam 的变换时,聚合是一个重要的概念。有关聚合的介绍,请参阅 Beam 模型基础知识 聚合部分。

Beam SDK 包含许多不同的变换,您可以将它们应用于管道的 PCollection。这些变换包括通用核心变换,例如 ParDo 或 Combine。SDK 中还包含预先编写的 组合变换,它们将一个或多个核心变换组合在有用的处理模式中,例如计算集合中的元素或将它们组合在一起。您还可以定义自己的更复杂的组合变换,以满足您的管道的确切用例。

有关在 Python SDK 中应用各种变换的更深入教程,请阅读并完成 此 Colab 笔记本。

4.1. 应用转换

要调用变换,您必须将其应用于输入 PCollection。Beam SDK 中的每个变换都有一个通用的 apply 方法(或管道运算符 |)。调用多个 Beam 变换类似于方法链接,但有一个细微的差别:您将变换应用于输入 PCollection,并将变换本身作为参数传递,操作将返回输出 PCollection。 array 在 YAML 中,通过列出变换的输入来应用变换。这采用以下一般形式:

如果变换有多个 (非错误) 输出,则可以通过明确给出输出名称来标识各个输出。

对于线性管道,可以通过根据变换的顺序隐式确定输入(通过指定类型为 chain)来进一步简化此操作。例如:

由于 Beam 使用通用的 apply 方法用于 PCollection,因此您可以将变换按顺序链接在一起,也可以应用包含其他变换的嵌套变换(在 Beam SDK 中称为 组合变换)。

建议为每个新的 PCollection 创建一个新变量,以按顺序转换输入数据。Scope 可用于创建包含其他变换的函数(在 Beam SDK 中称为 组合变换)。

您应用管道变换的方式决定了管道的结构。将管道视为有向无环图是最好的方式,其中 PTransform 节点是子例程,它们接受 PCollection 节点作为输入,并发出 PCollection 节点作为输出。 例如,您可以将变换链接在一起以创建一个管道,该管道会依次修改输入数据: 例如,您可以依次对 PCollections 调用变换以修改输入数据:

此管道的图形如下所示:

图 1:包含三个顺序转换的线性管道。

但是,请注意,转换*不会消耗或以其他方式改变*输入集合 - 请记住,根据定义,PCollection 是不可变的。这意味着您可以对同一个输入 PCollection 应用多个转换来创建一个分支管道,如下所示

此分支管道的图形如下所示

图 2:分支管道。两个转换应用于单个包含数据库表行的 PCollection。

您还可以构建自己的复合转换,将多个转换嵌套在一个更大的转换中。复合转换对于构建可重用的一系列简单步骤特别有用,这些步骤在许多不同的地方使用。

管道语法允许将 PTransform 应用于 tuple 和 dict 的 PCollection,以用于接受多个输入的那些转换(例如 Flatten 和 CoGroupByKey)。

PTransform 也可以应用于任何 PValue,其中包括 Root 对象、PCollection、PValue 数组以及具有 PValue 值的对象。可以通过用 beam.P 包装它们来将转换应用于这些复合类型,例如 beam.P({left: pcollA, right: pcollB}).apply(transformExpectingTwoPCollections)。

PTransform 有两种类型,同步和异步,具体取决于其应用*是否涉及异步调用。AsyncTransform 必须使用 applyAsync 应用,并返回一个 Promise,该 Promise 必须在进一步的管道构建之前等待。

4.2. 核心 Beam 转换

Beam 提供以下核心转换,每个转换代表不同的处理范式

ParDoGroupByKeyCoGroupByKeyCombineFlattenPartition

Typescript SDK 提供了其中一些最基本的转换,作为 PCollection 本身的函数。

4.2.1. ParDo

ParDo 是 Beam 转换,用于通用并行处理。ParDo 处理范式类似于 Map/Shuffle/Reduce 风格算法的“Map”阶段:ParDo 转换会考虑输入 PCollection 中的每个元素,对该元素执行一些处理函数(您的用户代码),并向输出 PCollection 发射零个、一个或多个元素。

ParDo 可用于各种常见的 数据处理操作,包括

- 过滤数据集。您可以使用

ParDo来考虑PCollection中的每个元素,并将该元素输出到一个新的集合中或将其丢弃。 - 格式化或类型转换数据集中的每个元素。如果您的输入

PCollection包含类型或格式与您想要的不同的元素,您可以使用ParDo对每个元素执行转换并将结果输出到一个新的PCollection。 - 从数据集中的每个元素中提取部分。例如,如果您有一个包含多个字段的记录的

PCollection,您可以使用ParDo将您要考虑的字段解析到一个新的PCollection中。 - 对数据集中的每个元素执行计算。您可以使用

ParDo对PCollection的每个元素或某些元素执行简单或复杂的计算,并将结果输出为新的PCollection。

在这样的角色中,ParDo 是管道中常见的中间步骤。您可能会使用它从一组原始输入记录中提取特定字段,或将原始输入转换为不同的格式;您也可以使用 ParDo 将处理后的数据转换为适合输出的格式,例如数据库表行或可打印的字符串。

当您应用 ParDo 转换时,您需要以 DoFn 对象的形式提供用户代码。DoFn 是一个 Beam SDK 类,用于定义分布式处理函数。

在 Beam YAML 中,ParDo 操作由 MapToFields、Filter 和 Explode 转换类型表示。这些类型可以接受您选择的语言中的 UDF,而不是引入 DoFn 的概念。有关更多详细信息,请参阅关于映射函数的页面。

当您创建

DoFn的子类时,请注意,您的子类应遵守编写 Beam 转换用户代码的要求。

所有 DoFns 应使用通用 register.DoFnXxY[...] 函数注册。这允许 Go SDK 从任何输入/输出推断编码,注册 DoFn 以在远程运行器上执行,并通过反射优化 DoFns 的运行时执行。

// ComputeWordLengthFn is a DoFn that computes the word length of string elements.

type ComputeWordLengthFn struct{}

// ProcessElement computes the length of word and emits the result.

// When creating structs as a DoFn, the ProcessElement method performs the

// work of this step in the pipeline.

func (fn *ComputeWordLengthFn) ProcessElement(ctx context.Context, word string) int {

...

}

func init() {

// 2 inputs and 1 output => DoFn2x1

// Input/output types are included in order in the brackets

register.DoFn2x1[context.Context, string, int](&ComputeWordLengthFn{})

}4.2.1.1. 应用 ParDo

与所有 Beam 转换一样,您可以通过在输入 PCollection 上调用 apply 方法并将 ParDo 作为参数传递来应用 ParDo,如以下示例代码所示

与所有 Beam 转换一样,您可以通过在输入 PCollection 上调用 beam.ParDo 并将 DoFn 作为参数传递来应用 ParDo,如以下示例代码所示

beam.ParDo 将传入的 DoFn 参数应用于输入 PCollection,如以下示例代码所示

// The input PCollection of Strings.

PCollection<String> words = ...;

// The DoFn to perform on each element in the input PCollection.

static class ComputeWordLengthFn extends DoFn<String, Integer> { ... }

// Apply a ParDo to the PCollection "words" to compute lengths for each word.

PCollection<Integer> wordLengths = words.apply(

ParDo

.of(new ComputeWordLengthFn())); // The DoFn to perform on each element, which

// we define above.

# The input PCollection of Strings.

words = ...

# The DoFn to perform on each element in the input PCollection.

class ComputeWordLengthFn(beam.DoFn):

def process(self, element):

return [len(element)]

# Apply a ParDo to the PCollection "words" to compute lengths for each word.

word_lengths = words | beam.ParDo(ComputeWordLengthFn())// ComputeWordLengthFn is the DoFn to perform on each element in the input PCollection.

type ComputeWordLengthFn struct{}

// ProcessElement is the method to execute for each element.

func (fn *ComputeWordLengthFn) ProcessElement(word string, emit func(int)) {

emit(len(word))

}

// DoFns must be registered with beam.

func init() {

beam.RegisterType(reflect.TypeOf((*ComputeWordLengthFn)(nil)))

// 2 inputs and 0 outputs => DoFn2x0

// 1 input => Emitter1

// Input/output types are included in order in the brackets

register.DoFn2x0[string, func(int)](&ComputeWordLengthFn{})

register.Emitter1[int]()

}

// words is an input PCollection of strings

var words beam.PCollection = ...

wordLengths := beam.ParDo(s, &ComputeWordLengthFn{}, words)# The input PCollection of Strings.

const words : PCollection<string> = ...

# The DoFn to perform on each element in the input PCollection.

function computeWordLengthFn(): beam.DoFn<string, number> {

return {

process: function* (element) {

yield element.length;

},

};

}

const result = words.apply(beam.parDo(computeWordLengthFn()));在本例中,我们的输入 PCollection 包含 String string 值。我们应用了一个 ParDo 转换,该转换指定一个函数(ComputeWordLengthFn)来计算每个字符串的长度,并将结果输出到一个新的 PCollection,其中包含 Integer int 值,用于存储每个单词的长度。

4.2.1.2. 创建 DoFn

您传递给 ParDo 的 DoFn 对象包含应用于输入集合中元素的处理逻辑。当您使用 Beam 时,您编写的最重要的代码通常是这些 DoFn - 它们定义了管道的精确数据处理任务。

注意:当您创建

DoFn时,请注意编写 Beam 转换用户代码的要求,并确保您的代码遵循这些要求。您应该避免在DoFn.Setup中进行耗时的操作,例如读取大型文件。

DoFn 从输入 PCollection 中一次处理一个元素。当您创建 DoFn 的子类时,您需要提供与输入和输出元素类型匹配的类型参数。如果您的 DoFn 处理传入的 String 元素并为输出集合生成 Integer 元素(例如我们之前的示例 ComputeWordLengthFn),您的类声明将如下所示

DoFn 从输入 PCollection 中一次处理一个元素。当您创建 DoFn 结构时,您需要提供与 ProcessElement 方法中输入和输出元素类型匹配的类型参数。如果您的 DoFn 处理传入的 string 元素并为输出集合生成 int 元素(例如我们之前的示例 ComputeWordLengthFn),您的 dofn 可能如下所示

// ComputeWordLengthFn is a DoFn that computes the word length of string elements.

type ComputeWordLengthFn struct{}

// ProcessElement computes the length of word and emits the result.

// When creating structs as a DoFn, the ProcessElement method performs the

// work of this step in the pipeline.

func (fn *ComputeWordLengthFn) ProcessElement(word string, emit func(int)) {

...

}

func init() {

// 2 inputs and 0 outputs => DoFn2x0

// 1 input => Emitter1

// Input/output types are included in order in the brackets

register.Function2x0(&ComputeWordLengthFn{})

register.Emitter1[int]()

}在您的 DoFn 子类中,您将编写一个用 @ProcessElement 注释的方法,您将在其中提供实际的处理逻辑。您无需手动从输入集合中提取元素;Beam SDK 会为您处理。您的 @ProcessElement 方法应接受一个用 @Element 标记的参数,该参数将用输入元素填充。为了输出元素,该方法还可以接受一个类型为 OutputReceiver 的参数,该参数提供一个用于发射元素的方法。参数类型必须与您的 DoFn 的输入和输出类型匹配,否则框架将引发错误。注意:@Element 和 OutputReceiver 是在 Beam 2.5.0 中引入的;如果使用早期版本的 Beam,应改用 ProcessContext 参数。

在您的 DoFn 子类中,您将编写一个 process 方法,您将在其中提供实际的处理逻辑。您无需手动从输入集合中提取元素;Beam SDK 会为您处理。您的 process 方法应接受一个参数 element,它是输入元素,并返回一个包含其输出值的迭代器。您可以通过使用 yield 语句发射单个元素来实现这一点,并使用 yield from 来发射来自迭代器(例如列表或生成器)的所有元素。使用包含迭代器的 return 语句也是可以接受的,只要您不要在同一个 process 方法中混合 yield 和 return 语句,因为这会导致不正确行为。

对于您的 DoFn 类型,您将编写一个 ProcessElement 方法,您将在其中提供实际的处理逻辑。您无需手动从输入集合中提取元素;Beam SDK 会为您处理。您的 ProcessElement 方法应接受一个参数 element,它是输入元素。为了输出元素,该方法还可以接受一个函数参数,该参数可以被调用以发射元素。参数类型必须与您的 DoFn 的输入和输出类型匹配,否则框架将引发错误。

// ComputeWordLengthFn is the DoFn to perform on each element in the input PCollection.

type ComputeWordLengthFn struct{}

// ProcessElement is the method to execute for each element.

func (fn *ComputeWordLengthFn) ProcessElement(word string, emit func(int)) {

emit(len(word))

}

// DoFns must be registered with beam.

func init() {

beam.RegisterType(reflect.TypeOf((*ComputeWordLengthFn)(nil)))

// 2 inputs and 0 outputs => DoFn2x0

// 1 input => Emitter1

// Input/output types are included in order in the brackets

register.DoFn2x0[string, func(int)](&ComputeWordLengthFn{})

register.Emitter1[int]()

}简单的 DoFns 也可以编写为函数。

注意:无论使用结构化

DoFn类型还是函数式DoFn,都应在init块中向 beam 注册它们。否则它们可能无法在分布式运行器上执行。

注意:如果输入

PCollection中的元素是键值对,您可以分别使用element.getKey()或element.getValue()来访问键或值。

注意:如果输入

PCollection中的元素是键值对,您的 process element 方法必须分别有两个参数,用于每个键和值。类似地,键值对也作为单独的参数输出到单个发射器函数。

给定的 DoFn 实例通常会被调用一次或多次以处理一些任意元素包。但是,Beam 并不保证确切的调用次数;它可能会在给定的工作节点上多次调用它,以解决故障和重试问题。因此,您可以跨多个调用缓存信息到您的处理方法,但如果这样做,请确保实现不依赖于调用次数。

在您的处理方法中,您还需要满足一些不变性要求,以确保 Beam 和处理后端可以安全地序列化和缓存管道中的值。您的方法应满足以下要求

- 您不应该以任何方式修改

@Element注释或ProcessContext.sideInput()(来自输入集合的传入元素)返回的元素。 - 一旦您使用

OutputReceiver.output()输出了一个值,您就不应该以任何方式修改该值。

- 您不应该以任何方式修改提供给

process方法的element参数,或任何侧输入。 - 一旦您使用

yield或return输出了一个值,您就不应该以任何方式修改该值。

- 您不应该以任何方式修改提供给

ProcessElement方法的参数,或任何侧输入。 - 一旦您使用

发射器函数输出了一个值,您就不应该以任何方式修改该值。

4.2.1.3. 轻量级 DoFns 和其他抽象

如果您的函数相对简单,您可以通过提供一个轻量级的ParDo来简化您的使用DoFn,就像匿名内部类实例 一个 lambda 函数 一个匿名函数 传递给PCollection.map或PCollection.flatMap的函数。

以下是之前的示例,ParDo使用ComputeLengthWordsFn,其中DoFn指定为匿名内部类实例 一个 lambda 函数 一个匿名函数 一个函数

// The input PCollection.

PCollection<String> words = ...;

// Apply a ParDo with an anonymous DoFn to the PCollection words.

// Save the result as the PCollection wordLengths.

PCollection<Integer> wordLengths = words.apply(

"ComputeWordLengths", // the transform name

ParDo.of(new DoFn<String, Integer>() { // a DoFn as an anonymous inner class instance

@ProcessElement

public void processElement(@Element String word, OutputReceiver<Integer> out) {

out.output(word.length());

}

}));如果您的ParDo对输入元素进行一对一映射到输出元素 - 也就是说,对于每个输入元素,它应用一个产生正好一个输出元素的函数,您可以直接返回该元素。您可以使用更高级的MapElementsMap转换。MapElements可以接受一个匿名的 Java 8 lambda 函数,以获得更简洁的代码。

以下是使用MapElements Map直接返回的先前示例。

// The input PCollection.

PCollection<String> words = ...;

// Apply a MapElements with an anonymous lambda function to the PCollection words.

// Save the result as the PCollection wordLengths.

PCollection<Integer> wordLengths = words.apply(

MapElements.into(TypeDescriptors.integers())

.via((String word) -> word.length()));The Go SDK cannot support anonymous functions outside of the deprecated Go Direct runner.

func wordLengths(word string) int { return len(word) }

func init() { register.Function1x1(wordLengths) }

func applyWordLenAnon(s beam.Scope, words beam.PCollection) beam.PCollection {

return beam.ParDo(s, wordLengths, words)

}注意: 您可以将 Java 8 lambda 函数与其他几个 Beam 转换一起使用,包括

Filter、FlatMapElements和Partition。

注意: 匿名函数 DoFn 不适用于分布式运行器。建议使用命名函数并在

init()块中使用register.FunctionXxY注册它们。

4.2.1.4. DoFn 生命周期

这是一个序列图,它显示了 DoFn 在执行 ParDo 转换期间的生命周期。注释为管道开发人员提供了有用的信息,例如适用于对象的约束或特定情况,例如故障转移或实例重用。它们还提供了实例化用例。需要注意的三个关键点是

- 拆卸是尽力而为的,因此不能保证。

- 在运行时创建的 DoFn 实例数量取决于运行器。

- 对于 Python SDK,管道内容(如 DoFn 用户代码)被序列化为字节码。因此,

DoFn不应该引用不可序列化的对象,例如锁。要在同一进程中的多个DoFn实例之间管理对象的单个实例,请使用shared.py模块中的实用程序。

4.2.2. GroupByKey

GroupByKey 是一个 Beam 转换,用于处理键值对集合。它是一个并行归约操作,类似于 Map/Shuffle/Reduce 样式算法的 Shuffle 阶段。GroupByKey的输入是键值对的集合,表示一个多映射,其中集合包含多个具有相同键但值不同的对。给定这样一个集合,您可以使用GroupByKey收集与每个唯一键关联的所有值。

GroupByKey是聚合具有共同特征数据的良好方法。例如,如果您有一个存储客户订单记录的集合,您可能希望将来自同一邮政编码的所有订单分组在一起(其中键值对的“键”是邮政编码字段,“值”是记录的其余部分)。

让我们通过一个简单的示例用例来检查GroupByKey的机制,其中我们的数据集包含来自文本文件中的单词及其出现的行号。我们希望将共享相同单词(键)的所有行号(值)分组在一起,让我们可以看到文本中特定单词出现的所有位置。

我们的输入是一个键值对的PCollection,其中每个单词都是一个键,值是在文件中单词出现的那一行号。以下是输入集合中键值对的列表

cat, 1

dog, 5

and, 1

jump, 3

tree, 2

cat, 5

dog, 2

and, 2

cat, 9

and, 6

...

GroupByKey收集具有相同键的所有值,并输出一个新的对,该对包含唯一的键和与输入集合中该键关联的所有值的集合。如果我们将GroupByKey应用于我们上面的输入集合,输出集合将如下所示

cat, [1,5,9]

dog, [5,2]

and, [1,2,6]

jump, [3]

tree, [2]

...

因此,GroupByKey表示从多映射(多个键到单个值)到单映射(唯一键到值集合)的转换。

使用GroupByKey很简单

虽然所有 SDK 都具有GroupByKey转换,但使用GroupBy通常更自然。GroupBy转换可以通过对PCollection元素进行分组的属性名称参数化,或者通过一个函数来参数化,该函数将每个元素作为输入并映射到要进行分组的键。

// A PCollection of elements like

// {word: "cat", score: 1}, {word: "dog", score: 5}, {word: "cat", score: 5}, ...

const scores : PCollection<{word: string, score: number}> = ...

// This will produce a PCollection with elements like

// {key: "cat", value: [{ word: "cat", score: 1 },

// { word: "cat", score: 5 }, ...]}

// {key: "dog", value: [{ word: "dog", score: 5 }, ...]}

const grouped_by_word = scores.apply(beam.groupBy("word"));

// This will produce a PCollection with elements like

// {key: 3, value: [{ word: "cat", score: 1 },

// { word: "dog", score: 5 },

// { word: "cat", score: 5 }, ...]}

const by_word_length = scores.apply(beam.groupBy((x) => x.word.length));4.2.2.1 GroupByKey 和无界 PCollection

如果您使用的是无界PCollection,则必须使用非全局窗口或聚合触发器才能执行GroupByKey或CoGroupByKey。这是因为无界GroupByKey或CoGroupByKey必须等待所有具有特定键的数据被收集,但是对于无界集合,数据是无限的。窗口和/或触发器允许分组在无界数据流中的逻辑有限数据包上操作。

如果您确实将GroupByKey或CoGroupByKey应用于一组无界PCollection,而没有为每个集合设置非全局窗口策略、触发策略或两者,Beam 将在管道构建时生成 IllegalStateException 错误。

当使用GroupByKey或CoGroupByKey对应用了窗口策略的PCollection进行分组时,您要分组的所有PCollection必须使用相同的窗口策略和窗口大小。例如,您要合并的所有集合必须使用(假设)相同的 5 分钟固定窗口或每 30 秒开始的 4 分钟滑动窗口。

如果您的管道试图使用GroupByKey或CoGroupByKey合并具有不兼容窗口的PCollection,Beam 将在管道构建时生成 IllegalStateException 错误。

4.2.3. CoGroupByKey

CoGroupByKey对两个或多个具有相同键类型的键值PCollection执行关系连接。设计您的管道展示了一个使用连接的示例管道。

如果您有多个数据集提供了有关相关事物的的信息,请考虑使用CoGroupByKey。例如,假设您有两个不同的文件包含用户数据:一个文件包含姓名和电子邮件地址;另一个文件包含姓名和电话号码。您可以使用用户名作为公共键,将其他数据作为关联值来连接这两个数据集。连接后,您将拥有一个包含与每个姓名关联的所有信息(电子邮件地址和电话号码)的数据集。

也可以考虑使用 SqlTransform 执行连接。

如果您使用的是无界PCollection,则必须使用非全局窗口或聚合触发器才能执行CoGroupByKey。有关更多详细信息,请参阅GroupByKey 和无界 PCollection。

在 Beam SDK for Java 中,CoGroupByKey接受键控PCollection(PCollection<KV<K, V>>)元组作为输入。为了类型安全,SDK 要求您将每个PCollection作为KeyedPCollectionTuple的一部分传递。您必须为要传递给CoGroupByKey的KeyedPCollectionTuple中的每个输入PCollection声明一个TupleTag。作为输出,CoGroupByKey返回一个PCollection<KV<K, CoGbkResult>>,它按其公共键对来自所有输入PCollection的值进行分组。每个键(所有类型为K)将具有不同的CoGbkResult,它是一个从TupleTag<T>到Iterable<T>的映射。您可以使用在初始集合中提供的TupleTag访问CoGbkResult对象中的特定集合。

在 Beam SDK for Python 中,CoGroupByKey接受一个键控PCollection字典作为输入。作为输出,CoGroupByKey创建一个包含一个键值元组的单个输出PCollection,对应于输入PCollection中的每个键。每个键的值是一个字典,它将每个标签映射到对应PCollection中键下值的迭代器。

在 Beam Go SDK 中,CoGroupByKey接受任意数量的PCollection作为输入。作为输出,CoGroupByKey创建一个包含每个键的单个输出PCollection,以及每个输入PCollection的值迭代器函数。迭代器函数按它们提供给CoGroupByKey的顺序映射到输入PCollections。

以下概念示例使用两个输入集合来展示CoGroupByKey的机制。

第一组数据有一个名为emailsTag的TupleTag<String>,包含姓名和电子邮件地址。第二组数据有一个名为phonesTag的TupleTag<String>,包含姓名和电话号码。

第一组数据包含姓名和电子邮件地址。第二组数据包含姓名和电话号码。

final List<KV<String, String>> emailsList =

Arrays.asList(

KV.of("amy", "amy@example.com"),

KV.of("carl", "carl@example.com"),

KV.of("julia", "julia@example.com"),

KV.of("carl", "carl@email.com"));

final List<KV<String, String>> phonesList =

Arrays.asList(

KV.of("amy", "111-222-3333"),

KV.of("james", "222-333-4444"),

KV.of("amy", "333-444-5555"),

KV.of("carl", "444-555-6666"));

PCollection<KV<String, String>> emails = p.apply("CreateEmails", Create.of(emailsList));

PCollection<KV<String, String>> phones = p.apply("CreatePhones", Create.of(phonesList));emails_list = [

('amy', 'amy@example.com'),

('carl', 'carl@example.com'),

('julia', 'julia@example.com'),

('carl', 'carl@email.com'),

]

phones_list = [

('amy', '111-222-3333'),

('james', '222-333-4444'),

('amy', '333-444-5555'),

('carl', '444-555-6666'),

]

emails = p | 'CreateEmails' >> beam.Create(emails_list)

phones = p | 'CreatePhones' >> beam.Create(phones_list)type stringPair struct {

K, V string

}

func splitStringPair(e stringPair) (string, string) {

return e.K, e.V

}

func init() {

// Register DoFn.

register.Function1x2(splitStringPair)

}

// CreateAndSplit is a helper function that creates

func CreateAndSplit(s beam.Scope, input []stringPair) beam.PCollection {

initial := beam.CreateList(s, input)

return beam.ParDo(s, splitStringPair, initial)

}

var emailSlice = []stringPair{

{"amy", "amy@example.com"},

{"carl", "carl@example.com"},

{"julia", "julia@example.com"},

{"carl", "carl@email.com"},

}

var phoneSlice = []stringPair{

{"amy", "111-222-3333"},

{"james", "222-333-4444"},

{"amy", "333-444-5555"},

{"carl", "444-555-6666"},

}

emails := CreateAndSplit(s.Scope("CreateEmails"), emailSlice)

phones := CreateAndSplit(s.Scope("CreatePhones"), phoneSlice)const emails_list = [

{ name: "amy", email: "amy@example.com" },

{ name: "carl", email: "carl@example.com" },

{ name: "julia", email: "julia@example.com" },

{ name: "carl", email: "carl@email.com" },

];

const phones_list = [

{ name: "amy", phone: "111-222-3333" },

{ name: "james", phone: "222-333-4444" },

{ name: "amy", phone: "333-444-5555" },

{ name: "carl", phone: "444-555-6666" },

];

const emails = root.apply(

beam.withName("createEmails", beam.create(emails_list))

);

const phones = root.apply(

beam.withName("createPhones", beam.create(phones_list))

);- type: Create

name: CreateEmails

config:

elements:

- { name: "amy", email: "amy@example.com" }

- { name: "carl", email: "carl@example.com" }

- { name: "julia", email: "julia@example.com" }

- { name: "carl", email: "carl@email.com" }

- type: Create

name: CreatePhones

config:

elements:

- { name: "amy", phone: "111-222-3333" }

- { name: "james", phone: "222-333-4444" }

- { name: "amy", phone: "333-444-5555" }

- { name: "carl", phone: "444-555-6666" }CoGroupByKey之后,结果数据将包含与来自任何输入集合的每个唯一键关联的所有数据。

final TupleTag<String> emailsTag = new TupleTag<>();

final TupleTag<String> phonesTag = new TupleTag<>();

final List<KV<String, CoGbkResult>> expectedResults =

Arrays.asList(

KV.of(

"amy",

CoGbkResult.of(emailsTag, Arrays.asList("amy@example.com"))

.and(phonesTag, Arrays.asList("111-222-3333", "333-444-5555"))),

KV.of(

"carl",

CoGbkResult.of(emailsTag, Arrays.asList("carl@email.com", "carl@example.com"))

.and(phonesTag, Arrays.asList("444-555-6666"))),

KV.of(

"james",

CoGbkResult.of(emailsTag, Arrays.asList())

.and(phonesTag, Arrays.asList("222-333-4444"))),

KV.of(

"julia",

CoGbkResult.of(emailsTag, Arrays.asList("julia@example.com"))

.and(phonesTag, Arrays.asList())));results = [

(

'amy',

{

'emails': ['amy@example.com'],

'phones': ['111-222-3333', '333-444-5555']

}),

(

'carl',

{

'emails': ['carl@email.com', 'carl@example.com'],

'phones': ['444-555-6666']

}),

('james', {

'emails': [], 'phones': ['222-333-4444']

}),

('julia', {

'emails': ['julia@example.com'], 'phones': []

}),

]results := beam.CoGroupByKey(s, emails, phones)

contactLines := beam.ParDo(s, formatCoGBKResults, results)

// Synthetic example results of a cogbk.

results := []struct {

Key string

Emails, Phones []string

}{

{

Key: "amy",

Emails: []string{"amy@example.com"},

Phones: []string{"111-222-3333", "333-444-5555"},

}, {

Key: "carl",

Emails: []string{"carl@email.com", "carl@example.com"},

Phones: []string{"444-555-6666"},

}, {

Key: "james",

Emails: []string{},

Phones: []string{"222-333-4444"},

}, {

Key: "julia",

Emails: []string{"julia@example.com"},

Phones: []string{},

},

}const results = [

{

name: "amy",

values: {

emails: [{ name: "amy", email: "amy@example.com" }],

phones: [

{ name: "amy", phone: "111-222-3333" },

{ name: "amy", phone: "333-444-5555" },

],

},

},

{

name: "carl",

values: {

emails: [

{ name: "carl", email: "carl@example.com" },

{ name: "carl", email: "carl@email.com" },

],

phones: [{ name: "carl", phone: "444-555-6666" }],

},

},

{

name: "james",

values: {

emails: [],

phones: [{ name: "james", phone: "222-333-4444" }],

},

},

{

name: "julia",

values: {

emails: [{ name: "julia", email: "julia@example.com" }],

phones: [],

},

},

];以下代码示例使用CoGroupByKey连接两个PCollection,然后使用ParDo来使用结果。然后,代码使用标签来查找和格式化来自每个集合的数据。

以下代码示例使用CoGroupByKey连接两个PCollection,然后使用ParDo来使用结果。DoFn迭代器参数的顺序映射到CoGroupByKey输入的顺序。

PCollection<KV<String, CoGbkResult>> results =

KeyedPCollectionTuple.of(emailsTag, emails)

.and(phonesTag, phones)

.apply(CoGroupByKey.create());

PCollection<String> contactLines =

results.apply(

ParDo.of(

new DoFn<KV<String, CoGbkResult>, String>() {

@ProcessElement

public void processElement(ProcessContext c) {

KV<String, CoGbkResult> e = c.element();

String name = e.getKey();

Iterable<String> emailsIter = e.getValue().getAll(emailsTag);

Iterable<String> phonesIter = e.getValue().getAll(phonesTag);

String formattedResult =

Snippets.formatCoGbkResults(name, emailsIter, phonesIter);

c.output(formattedResult);

}

}));# The result PCollection contains one key-value element for each key in the

# input PCollections. The key of the pair will be the key from the input and

# the value will be a dictionary with two entries: 'emails' - an iterable of

# all values for the current key in the emails PCollection and 'phones': an

# iterable of all values for the current key in the phones PCollection.

results = ({'emails': emails, 'phones': phones} | beam.CoGroupByKey())

def join_info(name_info):

(name, info) = name_info

return '%s; %s; %s' %\

(name, sorted(info['emails']), sorted(info['phones']))

contact_lines = results | beam.Map(join_info)func formatCoGBKResults(key string, emailIter, phoneIter func(*string) bool) string {

var s string

var emails, phones []string

for emailIter(&s) {

emails = append(emails, s)

}

for phoneIter(&s) {

phones = append(phones, s)

}

// Values have no guaranteed order, sort for deterministic output.

sort.Strings(emails)

sort.Strings(phones)

return fmt.Sprintf("%s; %s; %s", key, formatStringIter(emails), formatStringIter(phones))

}

func init() {

register.Function3x1(formatCoGBKResults)

// 1 input of type string => Iter1[string]

register.Iter1[string]()

}

// Synthetic example results of a cogbk.

results := []struct {

Key string

Emails, Phones []string

}{

{

Key: "amy",

Emails: []string{"amy@example.com"},

Phones: []string{"111-222-3333", "333-444-5555"},

}, {

Key: "carl",

Emails: []string{"carl@email.com", "carl@example.com"},

Phones: []string{"444-555-6666"},

}, {

Key: "james",

Emails: []string{},

Phones: []string{"222-333-4444"},

}, {

Key: "julia",

Emails: []string{"julia@example.com"},

Phones: []string{},

},

}- type: MapToFields

name: PrepareEmails

input: CreateEmails

config:

language: python

fields:

name: name

email: "[email]"

phone: "[]"

- type: MapToFields

name: PreparePhones

input: CreatePhones

config:

language: python

fields:

name: name

email: "[]"

phone: "[phone]"

- type: Combine

name: CoGropuBy

input: [PrepareEmails, PreparePhones]

config:

group_by: [name]

combine:

email: concat

phone: concat

- type: MapToFields

name: FormatResults

input: CoGropuBy

config:

language: python

fields:

formatted:

"'%s; %s; %s' % (name, sorted(email), sorted(phone))"格式化后的数据如下所示

4.2.4. Combine

Combine Combine Combine Combine 是一个 Beam 转换,用于组合数据中的元素或值的集合。Combine有一些变体可以在整个PCollection上工作,还有一些变体可以组合键值对PCollection中每个键的值。

当您应用Combine转换时,您必须提供包含组合元素或值的逻辑的函数。组合函数应该是可交换的和可结合的,因为该函数不一定在具有给定键的所有值上恰好调用一次。由于输入数据(包括值集合)可能分布在多个工作器上,因此组合函数可能会被多次调用,以对值集合的子集执行部分组合。Beam SDK 还提供了一些用于常见数字组合操作的预构建组合函数,例如求和、最小值和最大值。

简单的组合操作,例如求和,通常可以实现为一个简单的函数。更复杂的组合操作可能需要您创建一个CombineFn的子类,该子类具有与输入/输出类型不同的累积类型。

CombineFn的结合性和可交换性允许运行器自动应用一些优化

- 组合器提升:这是最重要的优化。输入元素在每个键和窗口内组合,然后进行混洗,因此混洗的数据量可能会减少许多数量级。这种优化的另一个术语是“mapper 端组合”。

- 增量组合:当您的

CombineFn大幅减少数据大小时,在流式混洗时组合元素非常有用。这会将进行组合的成本分散到您的流式计算可能处于空闲状态的时间内。增量组合还会减少中间累积器的存储。

4.2.4.1. 使用简单函数的简单组合

Beam YAML 包含以下内置的 CombineFns:count、sum、min、max、mean、any、all、group 和 concat。来自其他语言的 CombineFns 也可以参考 (完整聚合文档) [https://beam.apache.org/documentation/sdks/yaml-combine/] 中的描述。 以下示例代码展示了一个简单的组合函数。 组合是通过使用 `combining` 方法修改分组转换来完成的。此方法需要三个参数:要组合的值(可以是输入元素的命名属性,也可以是整个输入的函数)、组合操作(可以是二元函数或 `CombineFn`),最后是输出对象中组合值的名称。// Sum a collection of Integer values. The function SumInts implements the interface SerializableFunction.

public static class SumInts implements SerializableFunction<Iterable<Integer>, Integer> {

@Override

public Integer apply(Iterable<Integer> input) {

int sum = 0;

for (int item : input) {

sum += item;

}

return sum;

}

}func sumInts(a, v int) int {

return a + v

}

func init() {

register.Function2x1(sumInts)

}

func globallySumInts(s beam.Scope, ints beam.PCollection) beam.PCollection {

return beam.Combine(s, sumInts, ints)

}

type boundedSum struct {

Bound int

}

func (fn *boundedSum) MergeAccumulators(a, v int) int {

sum := a + v

if fn.Bound > 0 && sum > fn.Bound {

return fn.Bound

}

return sum

}

func init() {

register.Combiner1[int](&boundedSum{})

}

func globallyBoundedSumInts(s beam.Scope, bound int, ints beam.PCollection) beam.PCollection {

return beam.Combine(s, &boundedSum{Bound: bound}, ints)

}所有 Combiners 应使用通用的 register.CombinerX[...] 函数进行注册。这使 Go SDK 能够从任何输入/输出推断出编码,注册 Combiner 以在远程运行器上执行,并通过反射优化 Combiner 的运行时执行。

当您的累加器、输入和输出都是相同类型时,应使用 Combiner1。它可以通过 register.Combiner1[T](&CustomCombiner{}) 调用,其中 T 是输入/累加器/输出的类型。

当您的累加器、输入和输出是 2 种不同类型时,应使用 Combiner2。它可以通过 register.Combiner2[T1, T2](&CustomCombiner{}) 调用,其中 T1 是累加器的类型,T2 是另一种类型。

当您的累加器、输入和输出是 3 种不同类型时,应使用 Combiner3。它可以通过 register.Combiner3[T1, T2, T3](&CustomCombiner{}) 调用,其中 T1 是累加器的类型,T2 是输入的类型,T3 是输出的类型。

4.2.4.2. 使用 CombineFn 进行高级组合

对于更复杂的组合函数,您可以定义一个 CombineFn 的子类。如果组合函数需要更复杂的累加器、必须执行额外的预处理或后处理、可能更改输出类型或考虑键,则应使用 CombineFn。

一个通用的组合操作包括五个操作。当您创建 CombineFn 的子类 时,您必须通过覆盖相应的方法提供五个操作。只有 MergeAccumulators 是必需的方法。其他方法将根据累加器类型具有默认解释。生命周期方法如下:

创建累加器 创建一个新的“本地”累加器。在示例情况下,取平均值,本地累加器跟踪值的运行总和(我们最终平均除法的分子值)和迄今为止累加的值的数量(分母值)。它可以在分布式环境中被调用任意次。

添加输入 将输入元素添加到累加器中,返回累加器值。在我们的示例中,它将更新总和并将计数加 1。它也可以并行调用。

合并累加器 将多个累加器合并为一个累加器;这是在最终计算之前组合多个累加器中数据的机制。在计算平均值的情况下,合并了代表除法每个部分的累加器。它可以多次在其输出上被调用。

提取输出 执行最终计算。在计算平均值的情况下,这意味着将所有值的组合总和除以累加的值的数量。它在最终合并的累加器上调用一次。

压缩 返回累加器的更紧凑的表示形式。在累加器跨网络发送之前调用此方法,并且在将值缓冲或以其他方式在添加到累加器时惰性地保留未处理的情况下很有用。Compact 应返回一个等效的累加器,但可能已修改。在大多数情况下,Compact 不是必需的。有关使用 Compact 的现实世界示例,请参阅 TopCombineFn 的 Python SDK 实现

以下示例代码展示了如何定义一个计算平均值的 CombineFn

public class AverageFn extends CombineFn<Integer, AverageFn.Accum, Double> {

public static class Accum {

int sum = 0;

int count = 0;

}

@Override

public Accum createAccumulator() { return new Accum(); }

@Override

public Accum addInput(Accum accum, Integer input) {

accum.sum += input;

accum.count++;

return accum;

}

@Override

public Accum mergeAccumulators(Iterable<Accum> accums) {

Accum merged = createAccumulator();

for (Accum accum : accums) {

merged.sum += accum.sum;

merged.count += accum.count;

}

return merged;

}

@Override

public Double extractOutput(Accum accum) {

return ((double) accum.sum) / accum.count;

}

// No-op

@Override

public Accum compact(Accum accum) { return accum; }

}pc = ...

class AverageFn(beam.CombineFn):

def create_accumulator(self):

return (0.0, 0)

def add_input(self, sum_count, input):

(sum, count) = sum_count

return sum + input, count + 1

def merge_accumulators(self, accumulators):

sums, counts = zip(*accumulators)

return sum(sums), sum(counts)

def extract_output(self, sum_count):

(sum, count) = sum_count

return sum / count if count else float('NaN')

def compact(self, accumulator):

# No-op

return accumulatortype averageFn struct{}

type averageAccum struct {

Count, Sum int

}

func (fn *averageFn) CreateAccumulator() averageAccum {

return averageAccum{0, 0}

}

func (fn *averageFn) AddInput(a averageAccum, v int) averageAccum {

return averageAccum{Count: a.Count + 1, Sum: a.Sum + v}

}

func (fn *averageFn) MergeAccumulators(a, v averageAccum) averageAccum {

return averageAccum{Count: a.Count + v.Count, Sum: a.Sum + v.Sum}

}

func (fn *averageFn) ExtractOutput(a averageAccum) float64 {

if a.Count == 0 {

return math.NaN()

}

return float64(a.Sum) / float64(a.Count)

}

func (fn *averageFn) Compact(a averageAccum) averageAccum {

// No-op

return a

}

func init() {

register.Combiner3[averageAccum, int, float64](&averageFn{})

}const meanCombineFn: beam.CombineFn<number, [number, number], number> =

{

createAccumulator: () => [0, 0],

addInput: ([sum, count]: [number, number], i: number) => [

sum + i,

count + 1,

],

mergeAccumulators: (accumulators: [number, number][]) =>

accumulators.reduce(([sum0, count0], [sum1, count1]) => [

sum0 + sum1,

count0 + count1,

]),

extractOutput: ([sum, count]: [number, number]) => sum / count,

};4.2.4.3. 将 PCollection 组合成单个值

使用全局组合将给定 PCollection 中的所有元素转换为单个值,在您的管道中表示为包含一个元素的新 PCollection。以下示例代码展示了如何应用 Beam 提供的 sum 组合函数来为 PCollection 的整数生成单个总和值。

4.2.4.4. 组合和全局窗口

如果您的输入 PCollection 使用默认的全局窗口,则默认行为是返回包含一个项目的 PCollection。该项目的价值来自您在应用 Combine 时指定的组合函数中的累加器。例如,Beam 提供的 sum 组合函数返回零值(空输入的总和),而 min 组合函数返回最大值或无限值。

要使 Combine 在输入为空时返回空的 PCollection,请在应用 Combine 转换时指定 .withoutDefaults,如以下代码示例所示

func returnSideOrDefault(d float64, iter func(*float64) bool) float64 {

var c float64

if iter(&c) {

// Side input has a value, so return it.

return c

}

// Otherwise, return the default

return d

}

func init() { register.Function2x1(returnSideOrDefault) }

func globallyAverageWithDefault(s beam.Scope, ints beam.PCollection) beam.PCollection {

// Setting combine defaults has requires no helper function in the Go SDK.

average := beam.Combine(s, &averageFn{}, ints)

// To add a default value:

defaultValue := beam.Create(s, float64(0))

return beam.ParDo(s, returnSideOrDefault, defaultValue, beam.SideInput{Input: average})

}const pcoll = root.apply(

beam.create([

{ player: "alice", accuracy: 1.0 },

{ player: "bob", accuracy: 0.99 },

{ player: "eve", accuracy: 0.5 },

{ player: "eve", accuracy: 0.25 },

])

);

const result = pcoll.apply(

beam

.groupGlobally()

.combining("accuracy", combiners.mean, "mean")

.combining("accuracy", combiners.max, "max")

);

const expected = [{ max: 1.0, mean: 0.685 }];4.2.4.5. 组合和非全局窗口

如果您的 PCollection 使用任何非全局窗口函数,则 Beam 不会提供默认行为。在应用 Combine 时,您必须指定以下选项之一

- 指定

.withoutDefaults,其中输入PCollection中为空的窗口在输出集合中也将为空。 - 指定

.asSingletonView,其中输出将立即转换为PCollectionView,这将为每个空窗口提供一个默认值,在用作侧面输入时使用。通常只有在您的管道Combine的结果稍后在管道中用作侧面输入时才需要使用此选项。

如果您的 PCollection 使用任何非全局窗口函数,则 Beam Go SDK 的行为与全局窗口相同。输入 PCollection 中为空的窗口在输出集合中也将为空。

4.2.4.6. 组合键控 PCollection 中的值

在创建键控 PCollection 后(例如,通过使用 GroupByKey 转换),一个常见的模式是将与每个键关联的值集合组合成一个合并的单一值。借鉴 GroupByKey 的先前示例,名为 groupedWords 的键分组 PCollection 如下所示

cat, [1,5,9]

dog, [5,2]

and, [1,2,6]

jump, [3]

tree, [2]

...

在上面的 PCollection 中,每个元素都具有一个字符串键(例如,“cat”)及其值的整数可迭代对象(在第一个元素中,包含 [1, 5, 9])。如果您的管道下一处理步骤组合了值(而不是单独考虑它们),您可以组合整数的可迭代对象以创建单个合并值,与每个键配对。这种 GroupByKey 后跟合并值集合的模式等效于 Beam 的 Combine PerKey 转换。您提供给 Combine PerKey 的组合函数必须是关联的归约函数或 CombineFn 的子类。

// PCollection is grouped by key and the Double values associated with each key are combined into a Double.

PCollection<KV<String, Double>> salesRecords = ...;

PCollection<KV<String, Double>> totalSalesPerPerson =

salesRecords.apply(Combine.<String, Double, Double>perKey(

new Sum.SumDoubleFn()));

// The combined value is of a different type than the original collection of values per key. PCollection has

// keys of type String and values of type Integer, and the combined value is a Double.

PCollection<KV<String, Integer>> playerAccuracy = ...;

PCollection<KV<String, Double>> avgAccuracyPerPlayer =

playerAccuracy.apply(Combine.<String, Integer, Double>perKey(

new MeanInts())));const pcoll = root.apply(

beam.create([

{ player: "alice", accuracy: 1.0 },

{ player: "bob", accuracy: 0.99 },

{ player: "eve", accuracy: 0.5 },

{ player: "eve", accuracy: 0.25 },

])

);

const result = pcoll.apply(

beam

.groupBy("player")

.combining("accuracy", combiners.mean, "mean")

.combining("accuracy", combiners.max, "max")

);

const expected = [

{ player: "alice", mean: 1.0, max: 1.0 },

{ player: "bob", mean: 0.99, max: 0.99 },

{ player: "eve", mean: 0.375, max: 0.5 },

];4.2.5. Flatten

Flatten Flatten Flatten Flatten 是 Beam 转换,适用于存储相同数据类型的 PCollection 对象。Flatten 将多个 PCollection 对象合并为单个逻辑 PCollection。

以下示例展示了如何应用 Flatten 转换来合并多个 PCollection 对象。

// Flatten takes a PCollectionList of PCollection objects of a given type.

// Returns a single PCollection that contains all of the elements in the PCollection objects in that list.

PCollection<String> pc1 = ...;

PCollection<String> pc2 = ...;

PCollection<String> pc3 = ...;

PCollectionList<String> collections = PCollectionList.of(pc1).and(pc2).and(pc3);

PCollection<String> merged = collections.apply(Flatten.<String>pCollections());也可以使用 FlattenWith 转换以更兼容链接的方式将 PCollection 合并到输出 PCollection 中。

也可以使用 FlattenWith 转换以更兼容链接的方式将 PCollection 合并到输出 PCollection 中。

FlattenWith 可以接受根 PCollection 生成转换(例如 Create 和 Read)以及已经构建的 PCollection,并将应用它们并将它们的输出扁平化为生成的输出 PCollection 中。

// Flatten taken an array of PCollection objects, wrapped in beam.P(...)

// Returns a single PCollection that contains a union of all of the elements in all input PCollections.

const fib = root.apply(

beam.withName("createFib", beam.create([1, 1, 2, 3, 5, 8]))

);

const pow = root.apply(

beam.withName("createPow", beam.create([1, 2, 4, 8, 16, 32]))

);

const result = beam.P([fib, pow]).apply(beam.flatten());在 Beam YAML 中,通常不需要显式扁平化,因为可以为将被隐式扁平化的任何转换列出多个输入。

4.2.5.1. 合并集合中的数据编码

默认情况下,输出 PCollection 的编码器与输入 PCollectionList 中第一个 PCollection 的编码器相同。但是,输入 PCollection 对象可以分别使用不同的编码器,只要它们都包含您在选定语言中相同的数据类型即可。

4.2.5.2. 合并窗口集合

当使用 Flatten 合并应用了窗口策略的 PCollection 对象时,您要合并的所有 PCollection 对象必须使用兼容的窗口策略和窗口大小。例如,您要合并的所有集合都必须(假设)使用相同的 5 分钟固定窗口或以 30 秒为间隔开始的 4 分钟滑动窗口。

如果您的管道尝试使用 Flatten 来合并具有不兼容窗口的 PCollection 对象,则在构建管道时,Beam 将生成 IllegalStateException 错误。

4.2.6. Partition

Partition Partition Partition Partition 是 Beam 转换,适用于存储相同数据类型的 PCollection 对象。Partition 将单个 PCollection 拆分为固定数量的较小集合。

在 Typescript SDK 中,Split 转换通常更自然地使用。

Partition 根据您提供的划分函数划分 PCollection 的元素。划分函数包含确定如何将输入 PCollection 的元素拆分为每个生成的划分 PCollection 的逻辑。划分数量必须在图构造时确定。例如,您可以在运行时将划分数量作为命令行选项传递(这将用于构建管道图),但您不能在管道中间(例如,根据在构建管道图后计算的数据)确定划分数量。

以下示例将 PCollection 分割为百分位数组。

// Provide an int value with the desired number of result partitions, and a PartitionFn that represents the

// partitioning function. In this example, we define the PartitionFn in-line. Returns a PCollectionList

// containing each of the resulting partitions as individual PCollection objects.

PCollection<Student> students = ...;

// Split students up into 10 partitions, by percentile:

PCollectionList<Student> studentsByPercentile =

students.apply(Partition.of(10, new PartitionFn<Student>() {

public int partitionFor(Student student, int numPartitions) {

return student.getPercentile() // 0..99

* numPartitions / 100;

}}));

// You can extract each partition from the PCollectionList using the get method, as follows:

PCollection<Student> fortiethPercentile = studentsByPercentile.get(4);# Provide an int value with the desired number of result partitions, and a partitioning function (partition_fn in this example).

# Returns a tuple of PCollection objects containing each of the resulting partitions as individual PCollection objects.

students = ...

def partition_fn(student, num_partitions):

return int(get_percentile(student) * num_partitions / 100)

by_decile = students | beam.Partition(partition_fn, 10)

# You can extract each partition from the tuple of PCollection objects as follows:

fortieth_percentile = by_decile[4]func decileFn(student Student) int {

return int(float64(student.Percentile) / float64(10))

}

func init() {

register.Function1x1(decileFn)

}

// Partition returns a slice of PCollections

studentsByPercentile := beam.Partition(s, 10, decileFn, students)

// Each partition can be extracted by indexing into the slice.

fortiethPercentile := studentsByPercentile[4]请注意,在 Beam YAML 中,PCollections 是通过字符串而不是整数值进行划分的。

4.3. 为 Beam 转换编写用户代码的要求

在构建 Beam 转换的用户代码时,您应该牢记执行的分布式性质。例如,您的函数可能在许多不同的机器上并行运行许多副本,并且这些副本独立运行,不与任何其他副本通信或共享状态。根据您为管道选择的 Pipeline Runner 和处理后端,您的用户代码函数的每个副本都可能被重试或多次运行。因此,您应该谨慎对待在用户代码中包含诸如状态依赖性之类的内容。

一般来说,您的用户代码必须至少满足以下要求

- 您的函数对象必须是可序列化的。

- 您的函数对象必须是线程兼容的,并且要意识到Beam SDK 不是线程安全的。

此外,建议您使您的函数对象幂等的。Beam 支持非幂等函数,但需要额外的思考才能确保在存在外部副作用时正确性。

注意:这些要求适用于

DoFn(用于 ParDo 转换的函数对象)、CombineFn(用于 Combine 转换的函数对象)和WindowFn(用于 Window 转换的函数对象)的子类。

注意:这些要求适用于

DoFn(用于 ParDo 转换的函数对象)、CombineFn(用于 Combine 转换的函数对象)和WindowFn(用于 Window 转换的函数对象)。

4.3.1. 可序列化

您提供给转换的任何函数对象必须是 **完全可序列化的**。这是因为需要对函数的副本进行序列化并传输到处理集群中的远程工作器。 用户代码的基本类(例如 DoFn、CombineFn 和 WindowFn)已经实现了 Serializable;但是,您的子类不能添加任何不可序列化的成员。 函数是可序列化的,只要它们已使用 register.FunctionXxY(对于简单函数)或 register.DoFnXxY(对于结构化 DoFn)注册,并且不是闭包。结构化 DoFn 将对其所有导出的字段进行序列化。未导出的字段无法序列化,将被静默忽略。 Typescript SDK 使用 ts-serialize-closures 来序列化函数(和其他对象)。对于非闭包函数,这开箱即用,并且也适用于闭包,只要所讨论的函数(及其引用的任何闭包)使用 ts-closure-transform 钩子(例如,使用 ttsc 代替 tsc)进行编译。或者,您可以调用 requireForSerialization("importableModuleDefiningFunc", {func}) 来 直接按名称注册函数,这样可能更不易出错。请注意,如果(通常在 Javascript 中)func 返回包含闭包的对象,仅注册 func 是不够的——如果使用,则必须注册其返回值。

您应该记住一些其他可序列化因素

- 瞬态未导出 函数对象中的字段 **不会** 传输到工作器实例,因为它们不会自动序列化。

- 避免在序列化之前加载包含大量数据的字段。

- 函数对象的各个实例不能共享数据。

- 在应用函数对象后对其进行变异将不会产生任何影响。

注意:使用匿名内部类实例在内联声明函数对象时要小心。在非静态上下文中,您的内部类实例将隐式包含指向封闭类的指针以及该类的状态。该封闭类也将被序列化,因此适用于函数对象本身的相同注意事项也适用于此外部类。

注意:无法检测函数是否为闭包。闭包会导致运行时错误和管道故障。尽可能避免使用匿名函数。

4.3.2. 线程兼容性

您的函数对象应该与线程兼容。函数对象的每个实例在工作器实例上一次由单个线程访问,除非您显式创建自己的线程。但是,请注意,**Beam SDK 不是线程安全的**。如果您在用户代码中创建自己的线程,则必须提供自己的同步。 请注意,函数对象中的静态成员不会传递到工作器实例,并且函数的多个实例可能从不同的线程访问。

4.3.3. 幂等性

建议您使您的函数对象幂等——也就是说,它可以根据需要重复或重试,而不会造成意外的副作用。支持非幂等函数,但是 Beam 模型不保证您的用户代码可能被调用或重试的次数;因此,保持您的函数对象幂等会使您的管道的输出确定性,并且您的转换的行为更可预测,也更易于调试。

4.4. 侧输入

除了主要的输入 PCollection 之外,您还可以以侧输入的形式向 ParDo 转换提供其他输入。侧输入是 DoFn 在每次处理输入 PCollection 中的元素时都可以访问的额外输入。当您指定侧输入时,您会创建一个其他数据的视图,该视图可以在处理每个元素时从 ParDo 转换的 DoFn 中读取。

如果您的 ParDo 需要在处理输入 PCollection 中的每个元素时注入其他数据,但其他数据需要在运行时确定(而不是硬编码),则侧输入很有用。此类值可能由输入数据确定,或者依赖于管道的不同分支。

所有侧输入可迭代对象应使用通用 register.IterX[...] 函数注册。这会优化可迭代对象的运行时执行。

4.4.1. 向 ParDo 传递侧输入

// Pass side inputs to your ParDo transform by invoking .withSideInputs.

// Inside your DoFn, access the side input by using the method DoFn.ProcessContext.sideInput.

// The input PCollection to ParDo.

PCollection<String> words = ...;

// A PCollection of word lengths that we'll combine into a single value.

PCollection<Integer> wordLengths = ...; // Singleton PCollection

// Create a singleton PCollectionView from wordLengths using Combine.globally and View.asSingleton.

final PCollectionView<Integer> maxWordLengthCutOffView =

wordLengths.apply(Combine.globally(new Max.MaxIntFn()).asSingletonView());

// Apply a ParDo that takes maxWordLengthCutOffView as a side input.

PCollection<String> wordsBelowCutOff =

words.apply(ParDo

.of(new DoFn<String, String>() {

@ProcessElement

public void processElement(@Element String word, OutputReceiver<String> out, ProcessContext c) {

// In our DoFn, access the side input.

int lengthCutOff = c.sideInput(maxWordLengthCutOffView);

if (word.length() <= lengthCutOff) {

out.output(word);

}

}

}).withSideInputs(maxWordLengthCutOffView)

);# Side inputs are available as extra arguments in the DoFn's process method or Map / FlatMap's callable.

# Optional, positional, and keyword arguments are all supported. Deferred arguments are unwrapped into their

# actual values. For example, using pvalue.AsIteor(pcoll) at pipeline construction time results in an iterable

# of the actual elements of pcoll being passed into each process invocation. In this example, side inputs are

# passed to a FlatMap transform as extra arguments and consumed by filter_using_length.

words = ...

# Callable takes additional arguments.

def filter_using_length(word, lower_bound, upper_bound=float('inf')):

if lower_bound <= len(word) <= upper_bound:

yield word

# Construct a deferred side input.

avg_word_len = (

words

| beam.Map(len)

| beam.CombineGlobally(beam.combiners.MeanCombineFn()))

# Call with explicit side inputs.

small_words = words | 'small' >> beam.FlatMap(filter_using_length, 0, 3)

# A single deferred side input.

larger_than_average = (

words | 'large' >> beam.FlatMap(

filter_using_length, lower_bound=pvalue.AsSingleton(avg_word_len))

)

# Mix and match.

small_but_nontrivial = words | beam.FlatMap(

filter_using_length,

lower_bound=2,

upper_bound=pvalue.AsSingleton(avg_word_len))

# We can also pass side inputs to a ParDo transform, which will get passed to its process method.

# The first two arguments for the process method would be self and element.

class FilterUsingLength(beam.DoFn):

def process(self, element, lower_bound, upper_bound=float('inf')):

if lower_bound <= len(element) <= upper_bound:

yield element

small_words = words | beam.ParDo(FilterUsingLength(), 0, 3)

...// Side inputs are provided using `beam.SideInput` in the DoFn's ProcessElement method.

// Side inputs can be arbitrary PCollections, which can then be iterated over per element

// in a DoFn.

// Side input parameters appear after main input elements, and before any output emitters.

words = ...

// avgWordLength is a PCollection containing a single element, a singleton.

avgWordLength := stats.Mean(s, wordLengths)

// Side inputs are added as with the beam.SideInput option to beam.ParDo.

wordsAboveCutOff := beam.ParDo(s, filterWordsAbove, words, beam.SideInput{Input: avgWordLength})

wordsBelowCutOff := beam.ParDo(s, filterWordsBelow, words, beam.SideInput{Input: avgWordLength})

// filterWordsAbove is a DoFn that takes in a word,

// and a singleton side input iterator as of a length cut off

// and only emits words that are beneath that cut off.

//

// If the iterator has no elements, an error is returned, aborting processing.

func filterWordsAbove(word string, lengthCutOffIter func(*float64) bool, emitAboveCutoff func(string)) error {

var cutOff float64

ok := lengthCutOffIter(&cutOff)

if !ok {

return fmt.Errorf("no length cutoff provided")

}

if float64(len(word)) > cutOff {

emitAboveCutoff(word)

}

return nil

}

// filterWordsBelow is a DoFn that takes in a word,

// and a singleton side input of a length cut off

// and only emits words that are beneath that cut off.

//

// If the side input isn't a singleton, a runtime panic will occur.

func filterWordsBelow(word string, lengthCutOff float64, emitBelowCutoff func(string)) {

if float64(len(word)) <= lengthCutOff {

emitBelowCutoff(word)

}

}

func init() {

register.Function3x1(filterWordsAbove)

register.Function3x0(filterWordsBelow)

// 1 input of type string => Emitter1[string]

register.Emitter1[string]()

// 1 input of type float64 => Iter1[float64]

register.Iter1[float64]()

}

// The Go SDK doesn't support custom ViewFns.

// See https://github.com/apache/beam/issues/18602 for details

// on how to contribute them!

// Side inputs are provided by passing an extra context object to

// `map`, `flatMap`, or `parDo` transforms. This object will get passed as an

// extra argument to the provided function (or `process` method of the `DoFn`).

// `SideInputParam` properties (generally created with `pardo.xxxSideInput(...)`)

// have a `lookup` method that can be invoked from within the process method.

// Let words be a PCollection of strings.

const words : PCollection<string> = ...

// meanLengthPColl will contain a single number whose value is the

// average length of the words

const meanLengthPColl: PCollection<number> = words

.apply(

beam

.groupGlobally<string>()

.combining((word) => word.length, combiners.mean, "mean")

)

.map(({ mean }) => mean);

// Now we use this as a side input to yield only words that are

// smaller than average.

const smallWords = words.flatMap(

// This is the function, taking context as a second argument.

function* keepSmall(word, context) {

if (word.length < context.meanLength.lookup()) {

yield word;

}

},

// This is the context that will be passed as a second argument.

{ meanLength: pardo.singletonSideInput(meanLengthPColl) }

);4.4.2. 侧输入和窗口

带窗口的 PCollection 可能是无限的,因此无法压缩成单个值(或单个集合类)。当您创建带窗口的 PCollection 的 PCollectionView 时,PCollectionView 表示每个窗口一个实体(每个窗口一个单例,每个窗口一个列表,等等)。

Beam 使用主输入元素的窗口来查找侧输入元素的相应窗口。Beam 将主输入元素的窗口投影到侧输入的窗口集中,然后使用来自结果窗口的侧输入。如果主输入和侧输入具有相同的窗口,则投影将提供完全对应的窗口。但是,如果输入具有不同的窗口,则 Beam 使用投影来选择最合适的侧输入窗口。

例如,如果主输入使用一分钟的固定时间窗口进行窗口化,而侧输入使用一小时的固定时间窗口进行窗口化,则 Beam 将主输入窗口投影到侧输入窗口集中,并从相应的长达一小时的侧输入窗口中选择侧输入值。

如果主输入元素存在于多个窗口中,则 processElement 会被多次调用,每个窗口调用一次。每次调用 processElement 都会投影主输入元素的“当前”窗口,因此每次可能提供不同的侧输入视图。

如果侧输入具有多个触发器触发,则 Beam 使用来自最新触发器触发的值。如果您使用具有单个全局窗口的侧输入并指定触发器,这将特别有用。

4.5. 附加输出

虽然 ParDo 始终生成一个主输出 PCollection(作为 apply 的返回值),但您也可以让 ParDo 生成任意数量的其他输出 PCollection。如果您选择具有多个输出,则 ParDo 会将所有输出 PCollection(包括主输出)捆绑在一起返回。

虽然 beam.ParDo 始终生成一个输出 PCollection,但您的 DoFn 可以生成任意数量的其他输出 PCollections,甚至根本不生成。如果您选择具有多个输出,则您的 DoFn 需要使用与输出数量匹配的 ParDo 函数调用。beam.ParDo2 用于两个输出 PCollection,beam.ParDo3 用于三个,依此类推,直到 beam.ParDo7。如果您需要更多,可以使用 beam.ParDoN,它将返回一个 []beam.PCollection。

虽然 ParDo 始终生成一个主输出 PCollection(作为 apply 的返回值)。如果您想具有多个输出,请在您的 ParDo 操作中发出具有不同属性的对象,然后使用 Split 将其拆分为多个 PCollection。

在 Beam YAML 中,通过将所有输出发出到单个 PCollection(可能带有额外的字段)来获得多个输出,然后使用 Partition 将此单个 PCollection 拆分为多个不同的 PCollection 输出。

4.5.1. 用于多个输出的标签

Split PTransform 将接受形式为 {tagA?: A, tagB?: B, ...} 的元素的 PCollection,并返回一个对象 {tagA: PCollection<A>, tagB: PCollection<B>, ...}。预期标签的集合将传递给操作;如何处理多个或未知标签可以通过传递非默认的 SplitOptions 实例来指定。

Go SDK 不使用输出标签,而是使用位置顺序来表示多个输出 PCollection。

// To emit elements to multiple output PCollections, create a TupleTag object to identify each collection

// that your ParDo produces. For example, if your ParDo produces three output PCollections (the main output

// and two additional outputs), you must create three TupleTags. The following example code shows how to

// create TupleTags for a ParDo with three output PCollections.

// Input PCollection to our ParDo.

PCollection<String> words = ...;

// The ParDo will filter words whose length is below a cutoff and add them to

// the main output PCollection<String>.

// If a word is above the cutoff, the ParDo will add the word length to an

// output PCollection<Integer>.

// If a word starts with the string "MARKER", the ParDo will add that word to an

// output PCollection<String>.

final int wordLengthCutOff = 10;

// Create three TupleTags, one for each output PCollection.

// Output that contains words below the length cutoff.

final TupleTag<String> wordsBelowCutOffTag =

new TupleTag<String>(){};

// Output that contains word lengths.

final TupleTag<Integer> wordLengthsAboveCutOffTag =

new TupleTag<Integer>(){};

// Output that contains "MARKER" words.

final TupleTag<String> markedWordsTag =

new TupleTag<String>(){};

// Passing Output Tags to ParDo:

// After you specify the TupleTags for each of your ParDo outputs, pass the tags to your ParDo by invoking

// .withOutputTags. You pass the tag for the main output first, and then the tags for any additional outputs

// in a TupleTagList. Building on our previous example, we pass the three TupleTags for our three output

// PCollections to our ParDo. Note that all of the outputs (including the main output PCollection) are

// bundled into the returned PCollectionTuple.

PCollectionTuple results =

words.apply(ParDo

.of(new DoFn<String, String>() {

// DoFn continues here.

...

})

// Specify the tag for the main output.

.withOutputTags(wordsBelowCutOffTag,

// Specify the tags for the two additional outputs as a TupleTagList.

TupleTagList.of(wordLengthsAboveCutOffTag)

.and(markedWordsTag)));# To emit elements to multiple output PCollections, invoke with_outputs() on the ParDo, and specify the

# expected tags for the outputs. with_outputs() returns a DoOutputsTuple object. Tags specified in

# with_outputs are attributes on the returned DoOutputsTuple object. The tags give access to the

# corresponding output PCollections.

results = (

words

| beam.ParDo(ProcessWords(), cutoff_length=2, marker='x').with_outputs(

'above_cutoff_lengths',

'marked strings',

main='below_cutoff_strings'))

below = results.below_cutoff_strings

above = results.above_cutoff_lengths

marked = results['marked strings'] # indexing works as well

# The result is also iterable, ordered in the same order that the tags were passed to with_outputs(),

# the main tag (if specified) first.

below, above, marked = (words

| beam.ParDo(

ProcessWords(), cutoff_length=2, marker='x')

.with_outputs('above_cutoff_lengths',

'marked strings',

main='below_cutoff_strings'))// beam.ParDo3 returns PCollections in the same order as

// the emit function parameters in processWords.

below, above, marked := beam.ParDo3(s, processWords, words)

// processWordsMixed uses both a standard return and an emitter function.

// The standard return produces the first PCollection from beam.ParDo2,

// and the emitter produces the second PCollection.

length, mixedMarked := beam.ParDo2(s, processWordsMixed, words)4.5.2. 在您的 DoFn 中发射到多个输出

根据需要调用发射器函数以生成与其匹配的 PCollection 的 0 个或多个元素。相同的值可以用多个发射器发出。像往常一样,在从任何发射器发出值后,不要对其进行变异。

所有发射器应使用通用 register.EmitterX[...] 函数注册。这会优化发射器的运行时执行。

DoFn 也可以通过标准返回来返回单个元素。标准返回始终是 beam.ParDo 返回的第一个 PCollection。其他发射器将其输出发送到其定义的参数顺序中的自己的 PCollection。

MapToFields 始终是一对一。要执行一对多映射,可以先将字段映射到可迭代类型,然后将此转换与 Explode 转换结合使用,该转换将发出多个值,每个值对应于已展开字段的值。

// Inside your ParDo's DoFn, you can emit an element to a specific output PCollection by providing a

// MultiOutputReceiver to your process method, and passing in the appropriate TupleTag to obtain an OutputReceiver.

// After your ParDo, extract the resulting output PCollections from the returned PCollectionTuple.

// Based on the previous example, this shows the DoFn emitting to the main output and two additional outputs.

.of(new DoFn<String, String>() {

public void processElement(@Element String word, MultiOutputReceiver out) {

if (word.length() <= wordLengthCutOff) {

// Emit short word to the main output.

// In this example, it is the output with tag wordsBelowCutOffTag.

out.get(wordsBelowCutOffTag).output(word);

} else {

// Emit long word length to the output with tag wordLengthsAboveCutOffTag.

out.get(wordLengthsAboveCutOffTag).output(word.length());

}

if (word.startsWith("MARKER")) {

// Emit word to the output with tag markedWordsTag.

out.get(markedWordsTag).output(word);

}

}}));# Inside your ParDo's DoFn, you can emit an element to a specific output by wrapping the value and the output tag (str).

# using the pvalue.OutputValue wrapper class.

# Based on the previous example, this shows the DoFn emitting to the main output and two additional outputs.

class ProcessWords(beam.DoFn):

def process(self, element, cutoff_length, marker):

if len(element) <= cutoff_length:

# Emit this short word to the main output.

yield element

else:

# Emit this word's long length to the 'above_cutoff_lengths' output.

yield pvalue.TaggedOutput('above_cutoff_lengths', len(element))

if element.startswith(marker):

# Emit this word to a different output with the 'marked strings' tag.

yield pvalue.TaggedOutput('marked strings', element)

# Producing multiple outputs is also available in Map and FlatMap.

# Here is an example that uses FlatMap and shows that the tags do not need to be specified ahead of time.

def even_odd(x):

yield pvalue.TaggedOutput('odd' if x % 2 else 'even', x)

if x % 10 == 0:

yield x

results = numbers | beam.FlatMap(even_odd).with_outputs()

evens = results.even

odds = results.odd

tens = results[None] # the undeclared main output// processWords is a DoFn that has 3 output PCollections. The emitter functions

// are matched in positional order to the PCollections returned by beam.ParDo3.

func processWords(word string, emitBelowCutoff, emitAboveCutoff, emitMarked func(string)) {

const cutOff = 5

if len(word) < cutOff {

emitBelowCutoff(word)

} else {

emitAboveCutoff(word)

}

if isMarkedWord(word) {

emitMarked(word)

}

}

// processWordsMixed demonstrates mixing an emitter, with a standard return.

// If a standard return is used, it will always be the first returned PCollection,

// followed in positional order by the emitter functions.

func processWordsMixed(word string, emitMarked func(string)) int {

if isMarkedWord(word) {

emitMarked(word)

}

return len(word)

}

func init() {

register.Function4x0(processWords)

register.Function2x1(processWordsMixed)

// 1 input of type string => Emitter1[string]

register.Emitter1[string]()

}4.5.3. 在您的 DoFn 中访问附加参数

除了元素和 OutputReceiver 之外,Beam 还将为您的 DoFn 的 @ProcessElement 方法填充其他参数。这些参数的任何组合都可以按任何顺序添加到您的处理方法中。

除了元素之外,Beam 还将为您的 DoFn 的 process 方法填充其他参数。这些参数可以通过将访问器放在上下文参数中获得,就像侧输入一样。

除了元素之外,Beam 还将为您的 DoFn 的 process 方法填充其他参数。这些参数可以通过将访问器放在上下文参数中获得,就像侧输入一样。

除了元素之外,Beam 还将为您的 DoFn 的 ProcessElement 方法填充其他参数。这些参数的任何组合都可以按标准顺序添加到您的处理方法中。

context.Context:为了支持合并的日志记录和用户定义的指标,可以请求 context.Context 参数。根据 Go 惯例,如果存在,则必须是 DoFn 方法的第一个参数。

时间戳:要访问输入元素的时间戳,请添加一个使用 @Timestamp 注释并类型为 Instant 的参数。例如

时间戳:要访问输入元素的时间戳,请添加一个关键字参数,默认值为 DoFn.TimestampParam。例如

时间戳:要访问输入元素的时间戳,请在元素之前添加一个 beam.EventTime 参数。例如

时间戳:要访问输入元素所属的窗口,请将 pardo.windowParam() 添加到上下文参数中。

窗口:要访问输入元素所属的窗口,请添加一个与输入 PCollection 使用的窗口类型相同的参数。如果参数是窗口类型(BoundedWindow 的子类),但不匹配输入 PCollection,则会引发错误。如果一个元素属于多个窗口(例如,这将在使用 SlidingWindows 时发生),则 @ProcessElement 方法将针对该元素被多次调用,每个窗口调用一次。例如,当使用固定窗口时,窗口的类型为 IntervalWindow。

窗口:要访问输入元素所属的窗口,请添加一个关键字参数,默认值为 DoFn.WindowParam。如果一个元素属于多个窗口(例如,这将在使用 SlidingWindows 时发生),则 process 方法将针对该元素被多次调用,每个窗口调用一次。

窗口: 要访问输入元素所在的窗口,请在元素之前添加 beam.Window 参数。如果一个元素落在多个窗口中(例如,当使用滑动窗口时会发生这种情况),那么 ProcessElement 方法将为该元素调用多次,每个窗口调用一次。由于 beam.Window 是一个接口,因此可以对窗口的具体实现进行类型断言。例如,当使用固定窗口时,窗口的类型为 window.IntervalWindow。

窗口: 要访问输入元素所在的窗口,请在上下文参数中添加 pardo.windowParam()。如果一个元素落在多个窗口中(例如,当使用 SlidingWindows 时会发生这种情况),那么该函数将为该元素调用多次,每个窗口调用一次。

PaneInfo: 当使用触发器时,Beam 提供了一个 PaneInfo 对象,其中包含有关当前触发的信息。使用 PaneInfo,您可以确定这是否是早期触发或晚期触发,以及该窗口已经为该键触发了多少次。

PaneInfo: 当使用触发器时,Beam 提供了一个 DoFn.PaneInfoParam 对象,其中包含有关当前触发的信息。使用 DoFn.PaneInfoParam,您可以确定这是否是早期触发或晚期触发,以及该窗口已经为该键触发了多少次。Python SDK 中此功能的实现尚未完全完成;请参阅 问题 17821了解更多信息。

PaneInfo: 当使用触发器时,Beam 提供了 beam.PaneInfo 对象,其中包含有关当前触发的信息。使用 beam.PaneInfo,您可以确定这是否是早期触发或晚期触发,以及该窗口已经为该键触发了多少次。

窗口: 要访问输入元素所在的窗口,请在上下文参数中添加 pardo.paneInfoParam()。使用 beam.PaneInfo,您可以确定这是否是早期触发或晚期触发,以及该窗口已经为该键触发了多少次。

func extractWordsFn(pn beam.PaneInfo, line string, emitWords func(string)) {

if pn.Timing == typex.PaneEarly || pn.Timing == typex.PaneOnTime {

// ... perform operation ...

}

if pn.Timing == typex.PaneLate {

// ... perform operation ...

}

if pn.IsFirst {

// ... perform operation ...

}

if pn.IsLast {

// ... perform operation ...

}

words := strings.Split(line, " ")

for _, w := range words {

emitWords(w)

}

}PipelineOptions: 始终可以通过将其作为参数添加到处理方法中来访问当前管道的 PipelineOptions。

@OnTimer 方法也可以访问许多这些参数。Timestamp、Window、键、PipelineOptions、OutputReceiver 和 MultiOutputReceiver 参数都可以在 @OnTimer 方法中访问。此外,@OnTimer 方法可以接受类型为 TimeDomain 的参数,该参数表示计时器是基于事件时间还是处理时间。有关计时器的更多详细信息,请参阅 Apache Beam 的及时(和有状态)处理 博客文章。

计时器和状态: 除了上述参数之外,用户定义的计时器和状态参数也可以在有状态的 DoFn 中使用。有关计时器和状态的更多详细信息,请参阅 Apache Beam 的及时(和有状态)处理 博客文章。

计时器和状态: 用户定义的状态和计时器参数可以在有状态的 DoFn 中使用。有关计时器和状态的更多详细信息,请参阅 Apache Beam 的及时(和有状态)处理 博客文章。

计时器和状态: 此功能尚未在 Typescript SDK 中实现,但我们欢迎 贡献。在此期间,希望使用状态和计时器的 Typescript 管道可以使用 跨语言转换 来实现。

class StatefulDoFn(beam.DoFn):

"""An example stateful DoFn with state and timer"""

BUFFER_STATE_1 = BagStateSpec('buffer1', beam.BytesCoder())

BUFFER_STATE_2 = BagStateSpec('buffer2', beam.VarIntCoder())

WATERMARK_TIMER = TimerSpec('watermark_timer', TimeDomain.WATERMARK)

def process(self,

element,

timestamp=beam.DoFn.TimestampParam,

window=beam.DoFn.WindowParam,

buffer_1=beam.DoFn.StateParam(BUFFER_STATE_1),

buffer_2=beam.DoFn.StateParam(BUFFER_STATE_2),

watermark_timer=beam.DoFn.TimerParam(WATERMARK_TIMER)):

# Do your processing here

key, value = element

# Read all the data from buffer1

all_values_in_buffer_1 = [x for x in buffer_1.read()]

if StatefulDoFn._is_clear_buffer_1_required(all_values_in_buffer_1):

# clear the buffer data if required conditions are met.

buffer_1.clear()

# add the value to buffer 2

buffer_2.add(value)

if StatefulDoFn._all_condition_met():

# Clear the timer if certain condition met and you don't want to trigger

# the callback method.

watermark_timer.clear()

yield element

@on_timer(WATERMARK_TIMER)

def on_expiry_1(self,

timestamp=beam.DoFn.TimestampParam,

window=beam.DoFn.WindowParam,

key=beam.DoFn.KeyParam,

buffer_1=beam.DoFn.StateParam(BUFFER_STATE_1),

buffer_2=beam.DoFn.StateParam(BUFFER_STATE_2)):

# Window and key parameters are really useful especially for debugging issues.

yield 'expired1'

@staticmethod

def _all_condition_met():

# some logic

return True

@staticmethod

def _is_clear_buffer_1_required(buffer_1_data):

# Some business logic

return True// stateAndTimersFn is an example stateful DoFn with state and a timer.

type stateAndTimersFn struct {

Buffer1 state.Bag[string]

Buffer2 state.Bag[int64]

Watermark timers.EventTime

}

func (s *stateAndTimersFn) ProcessElement(sp state.Provider, tp timers.Provider, w beam.Window, key string, value int64, emit func(string, int64)) error {

// ... handle processing elements here, set a callback timer...

// Read all the data from Buffer1 in this window.

vals, ok, err := s.Buffer1.Read(sp)

if err != nil {

return err

}

if ok && s.shouldClearBuffer(vals) {

// clear the buffer data if required conditions are met.

s.Buffer1.Clear(sp)

}

// Add the value to Buffer2.

s.Buffer2.Add(sp, value)

if s.allConditionsMet() {

// Clear the timer if certain condition met and you don't want to trigger

// the callback method.

s.Watermark.Clear(tp)

}

emit(key, value)

return nil

}

func (s *stateAndTimersFn) OnTimer(sp state.Provider, tp timers.Provider, w beam.Window, key string, timer timers.Context, emit func(string, int64)) error {

// Window and key parameters are really useful especially for debugging issues.

switch timer.Family {

case s.Watermark.Family:

// timer expired, emit a different signal

emit(key, -1)

}

return nil

}

func (s *stateAndTimersFn) shouldClearBuffer([]string) bool {

// some business logic

return false

}

func (s *stateAndTimersFn) allConditionsMet() bool {

// other business logic

return true

}4.6. 复合转换

转换可以具有嵌套结构,其中复杂转换执行多个更简单的转换(例如,多个 ParDo、Combine、GroupByKey 甚至其他复合转换)。这些转换称为复合转换。将多个转换嵌套到单个复合转换中可以使您的代码更模块化,更易于理解。

Beam SDK 附带了许多有用的复合转换。有关转换列表,请参阅 API 参考页面。

4.6.1. 复合转换示例

CountWords 转换是 WordCount 示例程序 中的复合转换示例。CountWords 是一个 PTransform 子类,它包含多个嵌套转换。

在其 expand 方法中, 该 CountWords 转换应用以下转换操作

- 它对输入文本行

PCollection应用ParDo,生成一个包含单个单词的输出PCollection。 - 它对包含单词的

PCollection应用 Beam SDK 库转换Count,生成一个包含键值对的PCollection。每个键代表文本中的一个单词,每个值代表该单词在原始数据中出现的次数。

public static class CountWords extends PTransform<PCollection<String>,

PCollection<KV<String, Long>>> {

@Override

public PCollection<KV<String, Long>> expand(PCollection<String> lines) {

// Convert lines of text into individual words.

PCollection<String> words = lines.apply(

ParDo.of(new ExtractWordsFn()));

// Count the number of times each word occurs.

PCollection<KV<String, Long>> wordCounts =

words.apply(Count.<String>perElement());

return wordCounts;

}

}# The CountWords Composite Transform inside the WordCount pipeline.

@beam.ptransform_fn

def CountWords(pcoll):

return (

pcoll

# Convert lines of text into individual words.

| 'ExtractWords' >> beam.ParDo(ExtractWordsFn())

# Count the number of times each word occurs.

| beam.combiners.Count.PerElement()

# Format each word and count into a printable string.

| 'FormatCounts' >> beam.ParDo(FormatCountsFn()))// CountWords is a function that builds a composite PTransform

// to count the number of times each word appears.

func CountWords(s beam.Scope, lines beam.PCollection) beam.PCollection {

// A subscope is required for a function to become a composite transform.

// We assign it to the original scope variable s to shadow the original

// for the rest of the CountWords function.

s = s.Scope("CountWords")

// Since the same subscope is used for the following transforms,

// they are in the same composite PTransform.

// Convert lines of text into individual words.

words := beam.ParDo(s, extractWordsFn, lines)

// Count the number of times each word occurs.

wordCounts := stats.Count(s, words)

// Return any PCollections that should be available after

// the composite transform.

return wordCounts

}注意: 由于

Count本身就是一个复合转换,因此CountWords也是一个嵌套复合转换。

4.6.2. 创建复合转换

Typescript SDK 中的 PTransform 只是一个接受并返回 PValue(例如 PCollection)的函数。

要创建自己的复合转换,请创建 PTransform 类的子类并覆盖 expand 方法以指定实际的处理逻辑。然后,您可以像使用 Beam SDK 中的内置转换一样使用此转换。

对于 PTransform 类类型参数,您将传递转换作为输入接受的 PCollection 类型,以及转换作为输出生成的类型。要将多个 PCollection 作为输入,或生成多个 PCollection 作为输出,请对相关类型参数使用其中一个多集合类型。

要创建自己的复合 PTransform,请在当前管道作用域变量上调用 Scope 方法。传递给此新子 Scope 的转换将成为同一复合 PTransform 的一部分。

为了能够重复使用您的复合体,请在正常的 Go 函数或方法中构建它。此函数接受一个作用域和输入 PCollections,并返回它生成的任何输出 PCollections。注意: 这样的函数不能直接传递给 ParDo 函数。

以下代码示例展示了如何声明一个 PTransform,它接受一个包含 String 的 PCollection 作为输入,并输出一个包含 Integer 的 PCollection

// CountWords is a function that builds a composite PTransform

// to count the number of times each word appears.

func CountWords(s beam.Scope, lines beam.PCollection) beam.PCollection {

// A subscope is required for a function to become a composite transform.

// We assign it to the original scope variable s to shadow the original

// for the rest of the CountWords function.

s = s.Scope("CountWords")

// Since the same subscope is used for the following transforms,

// they are in the same composite PTransform.

// Convert lines of text into individual words.

words := beam.ParDo(s, extractWordsFn, lines)

// Count the number of times each word occurs.

wordCounts := stats.Count(s, words)

// Return any PCollections that should be available after

// the composite transform.

return wordCounts

}在您的 PTransform 子类中,您需要覆盖 expand 方法。expand 方法是您添加 PTransform 的处理逻辑的地方。您的 expand 覆盖必须接受适当类型的输入 PCollection 作为参数,并指定输出 PCollection 作为返回值。

以下代码示例展示了如何覆盖上一个示例中声明的 ComputeWordLengths 类的 expand 方法

以下代码示例展示了如何调用 CountWords 复合 PTransform,并将其添加到您的管道中

只要您覆盖 PTransform 子类中的 expand 方法以接受适当的输入 PCollection(s)并返回相应的输出 PCollection(s),您就可以包含任意数量的转换。这些转换可以包括核心转换、复合转换或 Beam SDK 库中包含的转换。

您的复合 PTransform 可以包含任意数量的转换。这些转换可以包括核心转换、其他复合转换或 Beam SDK 库中包含的转换。它们还可以使用和返回任意数量的 PCollection,只要需要即可。

您的复合转换的参数和返回值必须与整个转换的初始输入类型和最终返回类型匹配,即使转换的中间数据类型发生了多次变化。

注意: PTransform 的 expand 方法不应由转换的用户直接调用。相反,您应该在 PCollection 本身上调用 apply 方法,并使用转换作为参数。这允许转换嵌套在管道结构中。

4.6.3. PTransform 样式指南

该 PTransform 样式指南 包含此处未包含的其他信息,例如样式指南、日志记录和测试指南以及特定于语言的注意事项。当您要编写新的复合 PTransforms 时,该指南是一个有用的起点。

5. 管道 I/O

当您创建管道时,您通常需要从某个外部来源读取数据,例如文件或数据库。同样,您可能希望您的管道将其结果数据输出到外部存储系统。Beam 为 许多常见的數據存储类型 提供了读写转换。如果您希望您的管道读取或写入内置转换不支持的數據存储格式,您可以 实现自己的读写转换。

5.1. 读取输入数据

读取转换从外部来源读取数据,并返回数据的 PCollection 表示,供您的管道使用。您可以在构建管道时使用读取转换来创建新的 PCollection,尽管在管道的开始处这样做最为常见。

5.2. 编写输出数据

写入转换将 PCollection 中的数据写入外部數據源。您通常在管道的末尾使用写入转换来输出管道的最终结果。但是,您可以在管道中的任何位置使用写入转换来输出 PCollection 的数据。

5.3. 基于文件的输入和输出数据

5.3.1. 从多个位置读取

许多读取转换支持从匹配您提供的 glob 运算符的多个输入文件读取数据。请注意,glob 运算符是特定于文件系统的,并且遵循特定于文件系统的 一致性模型。以下 TextIO 示例使用 glob 运算符(*)来读取给定位置中所有具有前缀“input-”和后缀“.csv”的匹配输入文件